Машинное обучение (МО) и искусственный интеллект (ИИ) оказывают влияние практически на любые аспекты бизнеса и личной жизни, пишет на портале TechTarget директор по исследованиям аналитической компании Enterprise Management Associates Торстен Волк.

Эта весьма дискуссионная тема, поскольку часто отсутствует четкое и разделяемое другими понимание, какие ожидания разумно связывать с МО/ИИ и как следует определять успех этих технологий. Тем не менее любой человек должен знать основы МО/ИИ. Не менее важно понимать, чего они не могут дать.

Состояние дел

МО/ИИ используют математические алгоритмы для преобразования набора входных переменных в конкретные прогнозы. МО может принимать обоснованные решения на основе входных переменных, с которыми никогда не имело дела прежде. Простым примером является самоуправляемый автомобиль. Он должен избегать наезда на пешеходов в любой ситуации, независимо от того, как выглядят пешеходы, как они одеты, насколько быстро передвигаются, каков их рост, как громко они говорят, есть ли у них что-то в руках, сидят ли они в инвалидном кресле и носят ли шляпу. Он должен избегать наезда независимо от дождя или снега, количества полос движения, наличия тротуара, ночью и днем. Словом, независимо от любых параметров ситуации.

Как обучить машину, чтобы она обладала столь широким спектром возможностей и не допускала дорогостоящих ошибок? В этом суть проблемы. Обучение машины вождению автомобиля потребовало многомиллионных инвестиций. Но в результате не был создан ИИ, который можно было бы применять для решения других проблем. Иными словами, обучение машины вождению автомобиля было длительным процессом решения отдельных задач, начиная с правил безопасности пешеходов и заканчивая выбором скорости, когда в поле зрения нет соответствующего дорожного знака. У многих из этих ситуаций больше чем одно измерение, а неправильное решение влечет существенные юридические последствия. Например, самоуправляемый автомобиль должен тормозить перед собакой, если это не создает угрозу человеческой жизни. Насколько далеко заходит модель МО во взвешивании различных вариантов? Пойдет ли ИИ на небольшую аварию ради спасения собаки? А что будет, если это произойдет с тягачом, к которому прицеплен большой фургон, на мосту во время снежного бурана? Должна ни автономная автомашина, чтобы избежать наезда, въехать на тротуар, если есть полная уверенность, что там нет пешеходов?

Как работает МО

Для обучения самоуправляемого автомобиля отправимся на нем в поездку. Или лучше совершим сотни тысяч поездок со всеми возможными водителями на различных машинах по разным дорогам в разное время суток по разным странам. Мы нашпигуем машину датчиками (лидар, видеокамеры, дистанционные сенсоры) и будем фиксировать все действия водителя (газ, движения руля, переключение передач, торможение), чтобы машина наблюдала как можно больше естественных ситуаций. Такое неконтролируемое обучение представляет нетривиальную задачу, поскольку требует множества дорогостоящих экспериментальных автомобилей и большой вычислительной мощности, однако его недостаточно. Оно не обеспечивает машину достаточно релевантной обратной связью, указывающей, какие действия следует предпринимать, а каких избегать. При неконтролируемом обучении машина будет присваивать негативный рейтинг в основном такому поведению, которое привело к реальному происшествию, например, к столкновению. А как оценивать решения, которые едва не привели к наезду на пешехода? Как оценивать дурные привычки, которые часто безобидны, но иногда могут приводить к серьезным происшествиям? Или дурные привычки, которые просто повышают риск возникновения пробок? Когда машина должна остановиться, чтобы пропустить полицию или скорую помощь? Список можно продолжить. Кроме того, вряд ли стоит позволить машине в учебных целях переехать пешехода. По мнению автомобилистов, программы МО/ИИ никогда не приобретут достаточного опыта в этой области. Другие методы, такие как использование симулятора или демонстрация машине снимков происшествий, являются вспомогательными и не заменяют анализа поступающих от сенсоров в реальном времени данных и обратной связи.

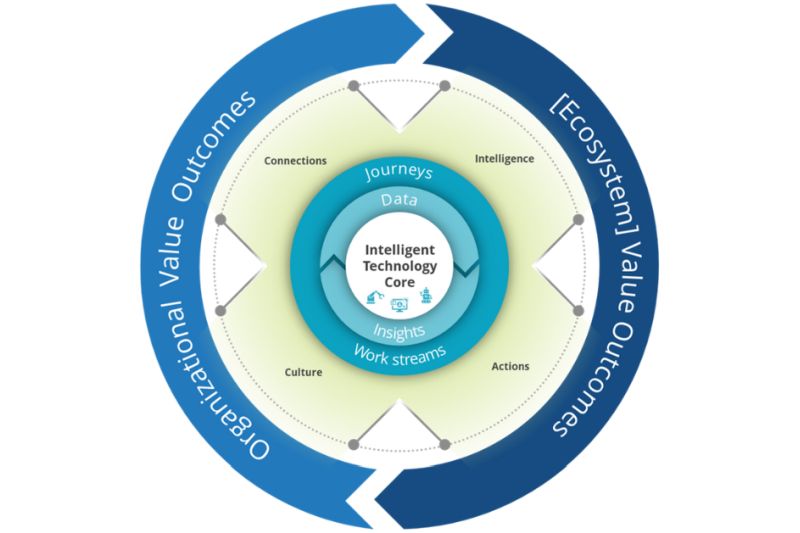

Что следует знать разработчикам о контролируемом МО

Контролируемое МО сопряжено со сложными техническими проблемами. Главным вопросом всех дискуссий вокруг МО является вопрос о необходимой степени вмешательства человека в этот процесс. Если сложность высока, а неудача будет иметь катастрофические последствия (как в случае с самоуправляемым автомобилем), необходимо вручную выполнить огромный объем работы по обучению и тестированию.

Шаги к контролируемому МО

Снабдите знанием предметной области. Словари — это, в сущности, плагины знаний для конкретных областей. В нашем примере с автомобилем словарь мог бы включать уже обученную модель МО, которая распознает дорожные знаки и реагирует на них корректными инструкциями по вождению. Разумеется, требуется некоторая работа вручную, чтобы управляющая автомобилем машина понимала эти инструкции.

Снабдите метками. Применительно к самодвижущимся автомашинам или компьютерным играм вроде World of Warcraft расстановка меток означает присвоение видеопотокам релевантных тегов. Метки выполняют роль учебных данных, информирующих машину о конкретных случаях, которые, по мнению человека, особенно важны или редки. Кстати, мнение человека представляет отдельную проблему МО.

Обеспечьте обратную связь. Либо предоставьте машине возможность получить негативный результат самостоятельно, либо замените его вручную. Недопустимо и противозаконно позволять самоуправляющемуся автомобилю попадать в происшествия, чтобы он обучался на своем негативном опыте. Поэтому люди занимаются контролируемым МО. Человек исправляет ошибки, чтобы предотвратить происшествия или дурные привычки, а алгоритм непрерывно обучается благодаря такой обратной связи.

Снабдите гиперпараметрами. Гиперпараметры описывают адресованные человеку требования принять решение, которое определяет, как должна обучаться машина. Этот вид контролируемого МО включает ответы на такие вопросы, как «Достаточно хорошо — насколько это хорошо?» и «В какой момент определенному алгоритму становится вредно обучаться на все новых исключительных случаях?». Хотя сегодня мы располагаем мощными и хорошо оптимизированными центральными и графическими процессорами, все же существуют ограничения на размер контекста, который способна обработать машина. Имеются в виду затраты и время отклика.

Решите, когда обучение завершено. Если вы обучаете машину играть в теннис, обучение завершается, когда она сможет победить любую программу игры в теннис и чемпиона по теннису среди людей. Но что, если вы обучаете машину выполнять функции администратора виртуальной сетевой инфраструктуры? В этом случае нет явного позитивного или негативного результата, связанного с каким-то действием. Имеется слишком много различных и равно обоснованных способов решить задачу выделения релевантных ситуационных факторов вместо того, чтобы охватывать их все. Последнее представляет нетривиальную задачу. Но даже если мы успешно с нею справимся, то как мы можем знать, что не существует многочисленных других столь же важных данных, встречающихся в других окружающих клиентов средах, которые мы даже не рассматривали, обучая машину? Возможность отсутствия потенциальных данных — еще одна значительная трудность контролируемого МО.

Проблема черного ящика

Это вопрос доверия решениям, которые принимает машина на основе контролируемого МО. Решения ИИ непрозрачны для людей. ИИ хранит знания в цифровой форме, их невозможно расшифровать, руководствуясь человеческой логикой. Например, когда машина учится распознавать изображение черепахи или наличие хот-дога на картинке, она хранит данные в матрице, описывающей многомерные корреляции на уровне отдельных пикселов. Конечно, приложив некоторые усилия, мы можем научить машину распознавать наличие определенных частей тела и делать на основании этого детальные выводы. Но это потребует большой работы и приведет к созданию системы МО, которую нелегко будет модифицировать.