Какие бы задачи ни решали размещённые в коммерческом дата-центре серверы, он в любом случае производит тепло — причём в огромных количествах, до мегаватт. Тепло это необходимо как минимум отводить, а ещё лучше утилизировать, не нанося ущерба окружающей среде и не ввергая дата-центр в дополнительные траты. Стандартные подходы к охлаждению ЦОДов отлично отработаны на малых и средних инсталляциях, однако на уровень мощности 5 МВт и более на крупные проекты типовые решения масштабируются не самым оптимальным образом. Один из крупнейших дата-центров столицы, в котором реализована нетривиальная по конструкции, эффективная и довольно быстро окупившая себя система отвода тепла, — это DataPro Moscow One площадью 16 тыс. кв. м, являет пример нетривиального подхода к организации системы охлаждения, обеспечивший высокую эффективность отвода тепла, дружественность к природе и возврат инвестиций в разумные сроки. О тенденциях рынка систем охлаждения для коммерческих ЦОДов в целом и о специфике данного конкретного проекта itWeek Expert рассказали Максим Чижов, руководитель направления по работе с заказчиками сегмента коммерческих ЦОДов подразделения Secure Power компании Schneider Electric, и Алексей Солдатов, генеральный директор DataPro.

Российский рынок коммерческих ЦОДов, по данным iKS-Consulting, вырос в 2018 г. на 16% — до 39,9 тыс. стоек. Каковы, на ваш взгляд, его актуальные особенности и дальнейшие перспективы?

Максим Чижов: По нашим наблюдениям и оценкам, нынешняя динамика роста этого рынка сохраняется. Тому есть и косвенные подтверждения: например, сокращение числа доступных для аренды стоек в коммерческих дата-центрах за последний год. Многие лидеры этого рынка заявляют о строительстве следующих очередей своих предприятий, о готовности инвестировать в дальнейшее их развитие: ЦОДы сейчас весьма и весьма востребованы. Доходит до того, что объекты, изначально задуманные как коммерческие, сразу после постройки выкупают целиком, как ЦОД «Авантаж» в подмосковном Лыткарине: возводился он как коммерческий дата-центр, но впоследствии его приобрела в собственность МТС. Эта довольно громкая сделка показательна с той точки зрения, что строительство коммерческих ЦОДов выгодно не только как инвестиция в долгосрочный проект по предоставлению услуг колокейшена, но и с точки зрения возможной продажи готового бизнеса. Одним словом, рынок этот развивается в России чрезвычайно динамично, и предпосылок для стагнации здесь не наблюдается.

Чем руководствуются заказчики, которые выбирают для своих задач именно коммерческие ЦОДы, а не большие облака и не локальные серверные решения? Насколько в принципе велик сегодня средний уровень экспертизы заказчика, какие особые требования к ЦОДу он может предъявлять?

М. Ч.: На мой взгляд, как представителя вендора оборудования для ЦОДов, заказчики в этом плане прежде всего руководствуются экономическими соображениями. Главная причина, безусловно,— экономия на строительстве собственных ЦОДов, уход от большого CAPEX в сторону достаточно растянутого во времени приемлемого OPEX с получением такого же, а то и выше, качества услуг по сравнению с собственным дата-центром.

Что же касается уровня экспертизы, которой владеют современные российские заказчики, то он достаточно велик. Все вопросы, касающиеся и инженерных систем дата-центра, и обеспечения в нём безопасности (в том числе информационной), подвергаются тщательному анализу технической или службой заказчика.

Получается, коммерческий ЦОД, чтобы привлечь данного клиента, должен в немалой мере учитывать его специфические запросы. Можно ли говорить о глубоко индивидуализированном подходе коммерческого ЦОДа буквально к каждому потенциальному клиенту как о типичной для сегодняшнего рынка ситуации? Что Schneider Electric готов предложить своим партнёрам в этом плане?

М. Ч.: Вопрос кастомизации в целом достаточно остро стоит на всех уровнях рынка. Мы всё чаще видим, как оператор коммерческого ЦОДа стремится модернизировать, улучшать свои системы, делает следующие их очереди более энергоэффективными. И предъявляет, соответственно, повышенные требования к оборудованию.

Для нас как для вендора это значит, что крупные заказчики всё реже выбирают серийно выпускаемое оборудование. Они выдвигают особые требования, с самого начала зная, на какие инженерные показатели (например, в холодоснабжении) хотят выйти и в какой бюджет при этом уложиться. Нас это стимулирует к дополнительным инвестициям в НИОКР, к разработке нерядовых технических решений. То же самое, думаю, происходит и во взаимоотношениях между оператором ЦОДа и его коммерческим клиентом. Модель сотрудничества и на этом уровне оказывается не общей, индивидуализированной.

Могу привести такой пример: на рынке ЦОДов заметен объективный тренд — увеличение плотности вычислительных мощностей в пересчёте на единичную стойку. Иными словами, каждая отдельная стойка потребляет всё больше электроэнергии и выделяет всё больше тепла. Операторы ЦОДов в стремлении обеспечить для оборудования штатный режим работы вынуждены искать некие особые технические решения, которые позволили бы им справляться с этой задачей наиболее эффективно.

Разумеется, задача эта чаще всего ретранслируется оператором ЦОДа производителю оборудования, и решение они ищут в дальнейшем совместно. Задача вендора в этом случае — базируясь на возможностях площадки, предложить такое решение из своего портфеля, которое удовлетворило бы конечного клиента, и притом не нанесло бы ущерба другим заинтересованным сторонам: и самому оператору, и соседям данного клиента по ЦОДу.

Поясню последний момент: высоконагруженные стойки, если они соседствуют в машинном зале с менее нагруженными, могут создавать эффект обкрадывания (технический термин) в плане кондиционирования. Поскольку тепловая нагрузка объективно сконцентрирована там, где расположена высоконагруженной стойка, все холодильные мощности сосредоточиваются на ней же. Для соседних стоек возникает таким образом риск недополучить какое-то количество воздуха или холода.

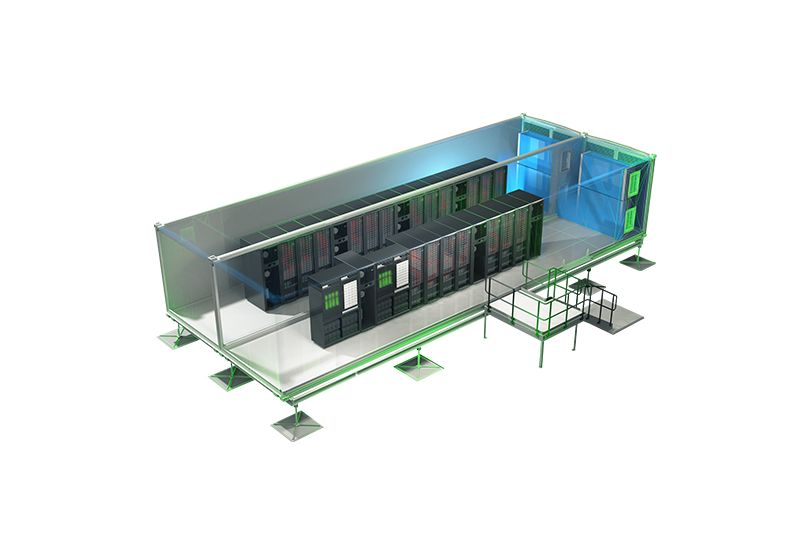

Для нас как для вендора очень важно иметь достаточно широкий и гибкий портфель решений — как раз для того, чтобы, исходя из каждой конкретной ситуации, предлагать тот или иной вариант. Решений таких у нас хватает: это и установка внутрирядных кондиционеров, и изоляция коридоров, и плитки активного фальшпола, через которые идёт кондиционирование, и многое другое. Нельзя не упомянуть и контейнерные ЦОДы — уникальное, сверхперсонифицированное решение для особых клиентов под особые задачи.

Как ЦОДам в условиях столь жёсткой конкуренции оптимизировать свои решения по себестоимости, чтобы предлагать заказчику лучшую цену не в ущерб собственным интересам? Возможно ли менять классическую схему инженерных коммуникаций, не поступаясь качеством услуги, но заметно экономя на технологическом «железе»?

М. Ч.: Вопрос оптимизации инженерных систем актуален всегда. Совершенство в этом смысле недостижимо, путь к нему — это постоянная, раз за разом всё более удачная аппроксимация. Создатели ЦОДов постоянно находятся в поиске новых технических решений, оптимизации стоимости, повышения отказоустойчивости и т. д, Сейчас, к примеру, очень многие операторы стали всерьёз рассматривать вопрос сертификации Tier IV, что прежде для российского рынка было абсолютно не характерно. Теперь же устроители коммерческих ЦОДов приходят к выводу, что путём незначительного увеличения затрат можно весьма существенно повысить общую. отказоустойчивость своего предприятия — и тем самым получить дополнительное конкурентное преимущество на рынке.

Мы как вендор тоже непрерывно оптимизируем свои технические решения, обновляем модельный ряд, производим по мере надобности кастомизацию оборудования под конкретного заказчика. Сейчас в принципе входит в моду такое явление, как ко-инжиниринг, совместное создание инженерной концепции оператором ЦОДа или его владельцем и производителем оборудования. Причём в основе ко-инжиниринговых практик лежит инициатива, идущая от заказчика: именно предъявляемые им требования заставляют формулировать новые технические задачи.

Алексей Солдатов: Когда мы приступили к планированию ЦОДа DataPro Moscow One в очень большом здании, сразу же остро встал вопрос об охлаждении. Оно могло быть водяным, фреоновым или воздушным. Водяное охлаждение при больших объёмах теплоотвода обходится крайне дорого из-за высокой цены инженерных коммуникаций. Фреон — это очень высокое давление в магистрали, и потому ограниченная длина трассы. А с воздухом проблема такая, что его нужно много, что делает холодильную установку громоздкой. Но зато — очень высокая эффективность.

При этом фреон — самый дешёвый: если говорить о больших объёмах, то 1 кВт холода обходится с использованием фреона где-то в 500 долл. с коэффициентом потерь

Что же в итоге сделали мы? В 2013 году использовали специализированное, основанное на адиабатическом эффекте (грубо говоря, на конечном участке организовали полив теплообменника водой), решение EcoBrеeze — благо, вода в РФ достаточно дешёва. При этом из 3 тыс. куб. м воды, которую наш ЦОД потребляет в месяц, 2 тыс. испаряются, а 1 тыс. сливается на газон. Вода выходит как раз не слишком солёной, ещё пригодной для полива, и довольно тёплой. Так что по соседству с нашим ЦОДом теперь — самый настоящий миниатюрный заливной луг площадью 200 кв. м, на котором трава растёт раза в три-четыре быстрее, чем в среднем в городе, и не выгорает даже в самую сушь.

Насколько важна для коммерческого ЦОДа минимизация сроков ввода в строй, развёртывания нового оборудования под конкретные запросы очередного заказчика?

М. Ч.: Если взять рынок ЦОДостроения в целом — не одного только коммерческого, — и обратить внимание на сроки строительства, ввода в строй и запуска в эксплуатацию, то мы увидим гигантскую разницу между коммерческими и всеми прочими дата-центрами. Типичный коммерческий ЦОД возводится заметно быстрее, чем любой корпоративный; причём вовсе не потому, что он меньше: наоборот, коммерческие ЦОДы по объёмам занимаемых зданий и по числу стоек всё крупнеют и крупнеют. Если несколько лет назад ЦОД на 500 стоек считался огромным, то сегодня серьёзные игроки о таких масштабах даже не задумываются: им интересен ввод в эксплуатацию, вывод на рынок ЦОДа на несколько тысяч шкафов. И если такая тенденция сохраниться, то в дальнейшем на рынок будут выходить коммерческие ЦОДы уже на десятки тысяч стоек, — да ещё и с увеличенной плотностью вычислительных средств внутри каждой отдельной стойки.

Так что скорость ввода в строй дата-центра как бизнес-предприятия действительно важна. Растёт она, по моему мнению, во многом за счёт оптимизации уже налаженных процессов, связанных со строительством, созданием дизайн-проекта, подбором и заказом оборудования. Вдобавок, коммерческие ЦОДы не обременены чрезмерно законодательной базой — и потому вольны все эти процессы проводить так, как считают правильным. Это и позволяет вводить объекты в эксплуатацию меньше чем за год, — за считанные месяцы иногда. Ведь чем раньше выходит ЦОД на рынок, тем большее преимуществ он получает. Особенно когда речь идёт о тех рынках, которые испытывают сегодня острый дефицит вычислительных мощностей.

Насколько в Schneider Electric развит консалтинг коммерческих ЦОДов по нерядовым индивидуальным проектам? Как компания помогает своим партнёрам откликаться на сложные запросы заказчиков — в плане проработки проекта, предоставления тестовых образцов, поставки, монтажа и сопровождения оборудования?

М. Ч.: Консалтинг у нас вполне развит. Есть особое подразделение, которое занимается разработкой концепций: его специалистам по силам не только создание дизайн-проекта, но и внедрение ЦОДа под ключ. В штате этой команды — пять человек с сертификатами Uptime Institute, что позволяет основывать наши рекомендации на самых актуальных мировых стандартах.

Если говорить о проекте, реализованном DataPro, то мы совместно с ними и основываясь на сформулированных ими требованиях разработали решение по холодоснабжению. Система холодоснабжения новых очередей организована в данном случае по принципу «точка-точка»: на каждый кондиционер приходится один чиллер, и связаны они между собой пластиковыми трубами. В результате — очень серьёзная экономия на материалах, высокая отказоустойчивость, быстрый и дешёвый монтаж, оперативный ввод в эксплуатацию.

Мы доработали специально для DataPro чиллер и внутренний блок кондиционера, модернизировав электрическую схему — так, чтобы электропитание на чиллер поступало через шину питания кондиционера. С учётом масштабности их ЦОДа одно только это обеспечило весьма приличную экономию на кабеле. Сегодня такое кастомизированное оборудование работает в штатном режиме, и в дальнейшем мы планируем двигаться в том же направлении. Ожидаем роста числа заказов на оборудование, построенное именно по такой схеме, доказавшей уже свою эффективность — и, насколько мне известно, пока что уникальной на рынке.

А. С.: Создавая ЦОДа DataPro Moscow One, мы опирались на несколько нетривиальных решений. Так, в модельном ряду компании Alfa Laval наше внимание привлекла холодильная машина, предназначенная совсем не для ЦОДов, а для охлаждения экструдеров, которые используются для выпуска различных пластиковых изделий. Обходится это устройство дороже чиллера, зато электричества почти не потребляет — за отсутствием компрессора внутри.

Произведя такой вот трансфер технологий в область ЦОДостроения, мы увидели, что с использованием массивного медного теплообменника и небольшим экономичным доохлаждением, мы с предлагаемыми Schneider Electric системами охлаждения гарантированно попадаем в современный диапазон разрешённых температур в машинном зале, — от 18 до 27 °С.

Дальше мы кардинально поменяли топологию: отказались от громадного водного коллектора на весь машинный зал и подсчитали, что если взять обычный шкафной кондиционер на воде, связанный обычной пластиковой трубой с небольшим чиллером, равным ему по мощности, позволяет генерировать холод крайне дёшево: максимум по 600 долл. за 1 кВт. Коэффициент потерь — тоже вполне приемлемый: 1,1, если использовать воду температуры

Мы пришли к такой топологии потому, что начали сознательно строить дата-центры как центры обработки данных, Это вовсе не тавтология: раньше во всём мире, и в России тоже, при планировании ЦОДов проектировщики просто брали технологию охлаждения крупного бизнес-центра — и масштабировали её где-то с 0,5 МВт холода до, скажем, 5 МВт. При этом линейное увеличение мощности магистралей приводило к квадратичному росту цены — за счёт высокой стоимости многочисленных задвижек и кранов, предназначенных для труб большого сечения.

Мы же поняли, что в случае дата-центра линейное масштабирование не всегда нужно. Например, если, грубо говоря, подключать все кондиционеры к одной трубе, выходит сложная конструкция со множеством задвижек, подверженная полной остановке в случае выхода из строя отдельного участка, крайне неудобная в обслуживании. Мы же практикуем другой подход: идти надо маленькими шагами, но делать их много. Изолируя холодильные машины, отказываясь от общей магистрали, мы получаем низкие OPEX и CAPEX, — плюс очень заметно выигрываем в надёжности.

Именно такой подход позволяет нам задумываться о переходе от Tier III к Tier IV, — прежде таких ЦОДов в России вообще не строилось. Притом переход на новый уровень сертификации, скорее всего, не заставит нас поднять цены: мы уже де-факто достаточно эффективны, осталось лишь получить официальное тому подтверждение. Важно, я считаю, задумывая построение очередного дата-центра, ориентироваться не только на технику, но прежде всего на топологию. Видеть в ЦОДе именно дата-центр с его специфическими технологическими процессами и клиентскими требованиями. И всегда подбирать оптимально соответствующее задаче оборудование, разумеется.

ПОДГОТОВЛЕНО ITWEEK EXPERT