Агентный искусственный интеллект рассматривается как следующая большая волна технологических инноваций, которая кардинально изменит процесс выполнения работы. Как нам говорят, благодаря новому классу все более точных и надежных моделей рассуждений агенты ИИ автоматизируют большое количество задач, которые в настоящее время требуют человеческого вмешательства. История звучит убедительно, но насколько она реальна, а не является технологической фантазией? Отвечают опрошенные порталом BigDATAwire эксперты.

Несомненно, компании исследуют ИИ и вкладывают большие суммы в проекты по его внедрению. Некоторые из этих проектов успешны, но большинство, вероятно, не успешны. Само по себе это не повод для тревоги, поскольку многие новые технологии сталкиваются с проблемами на ранних этапах внедрения. Главный вопрос заключается в том, как быстро мы преодолеем эти трудности и как в конечном итоге будет выглядеть внедрение ИИ на предприятиях.

На данный момент, если вы являетесь ИТ-поставщиком или ИТ-консультантом и ИИ не является частью вашей стратегии, вы вряд ли получите много обратных звонков.

«ИИ занимает центральное место во всех наших обсуждениях, — говорит Рам Паланиаппан, технический директор компании TEKsystem, ИТ-консультанта с глобальным доходом в 7 млрд. долл. — Если вы позиционируете себя без подхода „AI-first“, клиенты не захотят вас слушать... Они почувствуют, что вы где-то отстаете».

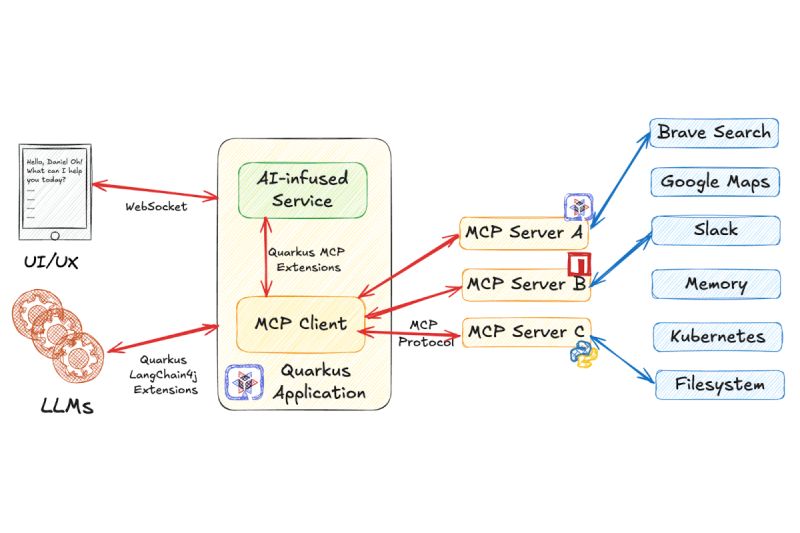

TEKsystem сотрудничает со многими крупными международными компаниями, помогая им создавать свои системы ИИ. По словам Паланиаппана, большая часть работы связана с использованием больших языковых моделей (LLM) для обеспечения более индивидуализированного опыта в таких областях, как обслуживание клиентов. Консалтинговая компания использует такие инструменты, как LangChain и Llama Index, для автоматизации некоторых из этих рабочих процессов генеративного ИИ.

Однако некоторые клиенты уже обращаются за помощью в разработке ИИ-агентов. По словам Паланиаппана, эта область не так хорошо определена, как пространство LLM, и потребуется некоторое время, чтобы инструменты стали более совершенными. «Мы видим, что использование агентного ИИ постепенно развивается, развиваются и инструменты в этой области. Интеграции, открытые стандарты для связи — все это развивается, — отмечает он. — Я бы сказал, что есть некоторые опережающие индикаторы, прежде всего с точки зрения внедрения, но в то же время есть и игра в догонялки, чтобы соответствовать требованиям».

Джулиан Ланив, технический директор компании Astronomer, также отмечает всплеск дискуссий вокруг агентного ИИ. Как компания, стоящая за Apache Airflow, Astronomer занимается доставкой данных туда, куда нужно, будь то хранилище данных для ситуативной аналитики или модель рассуждений для прогнозирования и принятия мер.

Однако Ланив не уверен, что некоторые из ранних примеров использования агентного ИИ стоят времени и затрат на работу со сложными и подверженными ошибкам технологиями. Например, технический директор одного из клиентов сказал ему, что хочет создать «мультиагентный рой», который поможет автоматизировать работу системы поддержки. Это показалось Ланиву перебором.

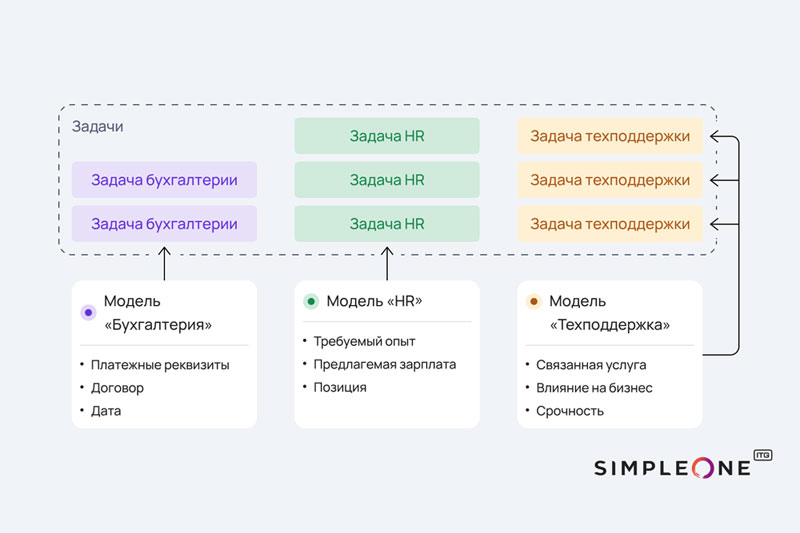

«Все, что вам нужно сделать, — это классифицировать тикет поддержки, а затем автоматически составить на него ответ. Это простой рабочий процесс, — говорит он. — Можно восхищаться тем, что могут делать эти LLM. Но некоторые люди сразу бросаются в омут с головой, пытаясь извлечь из них максимальный потенциал, прежде чем сделать простую и очевидную вещь».

Ланив отмечает, что LLM дают нам большое преимущество по сравнению с тем, как раньше выполнялась обработка естественного языка (NLP). Вместо того чтобы создавать команду машинного обучения и затем обучать пользовательскую модель на терминах, которые часто встречаются в компании, гораздо дешевле и проще использовать готовые LLM для классификации и даже потенциального ответа на такие вещи, как заявки в службу ИТ-поддержки.

«Простейший пример — цепочка подсказок, — рассказывает Ланив. — То есть вы можете использовать LLM в качестве первого шага конвейера, второго шага конвейера, третьего шага и, в конечном счете, что-то получить. Хороший пример — LlamaIndex или LangChain или что-то в этом роде».

Но в некоторых случаях даже такие инструменты, как LangChain и LlamaIndex, могут оказаться излишними. Так, Ланив видел, как многие компании создали надежные рабочие процессы ИИ с помощью Apache Airflow. По его словам, это достаточно гибкая платформа для оркестровки рабочих процессов, и неважно, обращаетесь ли вы к инструментам обработки данных, MО-инструментам или ИИ-инструментам, принципы работы остаются практически теми же. «Мы видим, как многие команды по нескольку раз в день без особых усилий создают новые рабочие процессы LLM, и это очень быстро увеличивает их количество, — говорит Ланив. — Каждый отдельный рабочий процесс LLM сам по себе может быть не так уж интересен. Может быть, он дает вам дополнительные

Внезапная увлеченность агентными нагрузками ИИ кажется Ланиву классическим случаем, когда технологи одержимы новыми технологиями вместо того, чтобы разобраться, какие технологии могут решить реальные бизнес-задачи. Поскольку все LLM и модели рассуждений склонны к галлюцинациям, вы также увеличиваете вероятность появления ошибок в рабочих процессах, если полностью исключаете человека из процесса, как многие хотят сделать с агентным ИИ.

«Я не против агентов в долгосрочной перспективе, я бы не стал так далеко заходить, — говорит Ланив. — Но я против того, чтобы начинать с агентов до того, как вы получите реальную пользу от сценариев использования отдельных рабочих процессов».