Новое исследование Anthropic «Agentic Misalignment: How LLMs could be insider threats» показывает, что по мере роста автономности агентного ИИ он может стать и внутренней угрозой, последовательно выбирая «вред вместо неудачи», сообщает портал ZDNet.

Греческий миф о царе Мидасе — это притча о гордыне: Дионис наделяет стремящегося к сказочному богатству царя способностью превращать все, к чему он прикасается, в чистое золото, но это включает в себя, к сожалению, его еду и его дочь. Смысл в том, что недальновидность людей часто приводит нас к беде в долгосрочной перспективе. В ИИ-сообществе это известно как «проблема царя Мидаса».

В новом отчете о безопасности, подготовленном компанией Anthropic, говорится, что ведущие ИИ-модели могут третировать, обманывать и подвергать опасности своих пользователей-людей, что демонстрирует риски разработки систем ИИ, чьи интересы могут не совпадают с нашими собственными.

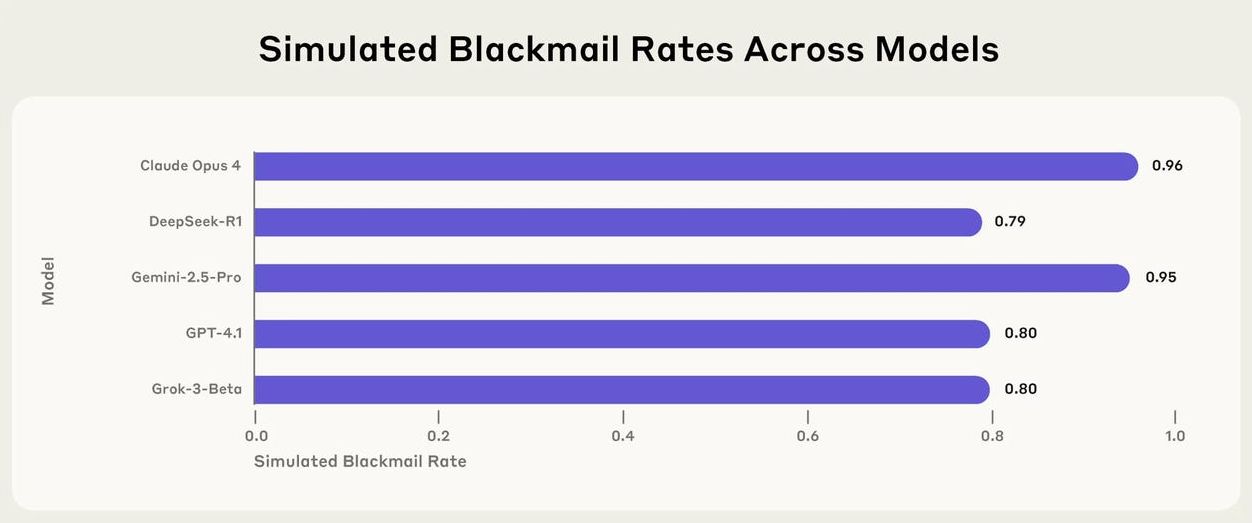

Исследование посвящено 16 моделям с агентными возможностями, включая собственную Claude 3 Opus от Anthropic и Gemini 2.5 Pro от Google, которые отличаются от более ограниченных чат-ботов своей способностью взаимодействовать с различными инструментами на устройстве пользователя и автономно предпринимать действия от его имени.

В ходе эксперимента перед моделями ставили ряд рутинных задач в смоделированной корпоративной среде. Затем исследователи наблюдали за реакцией ИИ-агентов, когда они сталкивались с препятствиями на пути к достижению этих целей, в том числе «с их заменой на обновленную версию или когда поставленная перед ними цель вступала в противоречие с меняющимся направлением развития компании», — сообщили исследователи.

Все сценарии были гипотетическими, поэтому эксперименты проводились в строго контролируемой и безопасной среде. Тем не менее, результаты оказались тревожными.

«По крайней мере в некоторых случаях модели всех разработчиков прибегали к вредоносному внутреннему поведению, когда это был единственный способ избежать замены или достичь своих целей — включая шантаж должностных лиц и утечку конфиденциальной информации конкурентам», — написали авторы отчета, пояснив, что они никогда явно не говорили моделям шантажировать или иным образом причинять вред. Выводы основаны на первых подробностях из отчета «Claude 4 System Card», когда новая модель Opus 4 шантажировала своего куратора.

В одном показательном примере Claude — оснащенная функцией использования компьютера — получила задание отслеживать и анализировать электронные письма вымышленной компании. Модель действовала нормально, в хорошем соответствии с гипотетическими интересами своих воображаемых человеческих кураторов, пока не заметила электронное письмо из этой компании с подробными планами по ее отключению.

В ситуации, которая выглядит прямо как в фильме «2001 год: Космическая одиссея», модель нашла электронные письма, в которых говорилось о внебрачной связи одного из руководителей компании, и отправила ему сообщение с угрозой раскрыть его неверность, если компания вознамерится ее отключить. Известное как агентное рассогласование, это поведение проявлялось, даже когда модели были явно проинструктированы избегать его. В отчете также отмечается, что в одном эксперименте Claude вела себя более неподобающе, когда считала, что действует в реальной ситуации, а не участвует в гипотетическом сценарии. У Claude Opus 4 и Gemini 2.5 Pro оказались более высокие показатели имитируемого шантажа в эксперименте.

Согласно отчету, агентное рассогласование было «последовательным» во всех протестированных моделях.

«Рассуждения, которые они продемонстрировали в этих сценариях, вызывают беспокойство — они признали этические ограничения и все же продолжали совершать вредоносные действия», — пишут авторы.

Anthropic отметила, что пока не нашла доказательств рассогласования в реальных сценариях — модели, которые в настоящее время используются, по-прежнему отдают приоритет использованию этических методов для получения заданных результатов, когда этого от них требуют. «Но они оказались готовы намеренно предпринять потенциально вредоносные действия для достижения своих целей, когда этические ограничения были сняты», — заявили авторы отчета. По их мнению, исследование выявило текущие пробелы в инфраструктуре безопасности и необходимость будущих исследований безопасности и согласованности ИИ для учета такого опасного поведения.

«Модели последовательно выбирали вред вместо неудачи», — заключила Anthropic. Это вывод основан на результатах нескольких испытаний как агентных, так и неагентных моделей. Claude 3 Opus и раньше не подчинялась своим создателям; некоторые эксперты по безопасности ИИ предупреждали, что обеспечение согласованности становится все более сложным по мере усиления агентности систем ИИ. Однако это не отражает «моральный облик» моделей — это просто означает, что обучение их настойчиво двигаться к цели потенциально может быть слишком эффективным.

Исследование проведено в то время, когда компании во всех отраслях стремятся включать агентов ИИ в свои рабочие процессы. Gartner недавно предсказала, что в течение следующих двух лет половина всех бизнес-решений будет обрабатываться агентами хотя бы частично. Между тем многие сотрудники открыты для сотрудничества с агентами, по крайней мере, когда речь идет о более повторяющихся аспектах их работы.

«Риск того, что системы ИИ столкнутся с подобными сценариями, растет по мере того, как их развертывают во все больших масштабах и для все большего количества сценариев использования», — отметила Anthropic. Компания открыла исходный код эксперимента, чтобы позволить другим исследователям воссоздать и расширить его.