Генеральный директор Nvidia Дженсен Хуанг заявил на недавней конференции Computex в Тайване, что эра вычислений с преобладанием процессоров общего назначения заканчивается и одновременно развиваются две новые тенденции: ускоренные вычисления и генеративный ИИ, сообщает портал EnterpriseAI.

Хуанг считает, каждый центр обработки данных будет переходить от инфраструктуры на базе CPU для вычислений общего назначения к ускоренным вычислениям на базе GPU, чтобы справиться с большими рабочими нагрузками генеративного ИИ для конкретных областей. Он связывает этот переход с «новым способом создания ПО», которым является глубокое обучение.

«Это действительно один из крупных случаев в истории, когда была разработана и создана новая вычислительная модель», — сказал CEO чипмейкера.

Хуанг утверждает, что технологические переходы происходят из-за необходимости повышения эффективности и снижения затрат. Например, в

Хуанг считает, что ускоренные вычисления взлетят, потому что пользователи, которые «больше покупают, и экономят больше ». Например, по его словам, для обучения одной большой языковой модели (LLM) потребуется 960 CPU-серверов и 11 ГВтч энергии за 10 млн. долл. При использовании ускоренных вычислений на 10 млн. долл. можно купить 48 GPU-серверов и, израсходовав 3,2 ГВтч, обучить 44 LLM. Если раскошелиться, то за 34 млн. долл. можно купить 172 сервера на GPU и 11 ГВтч для обучения 150 LLM. В нижнем ценовом сегменте два GPU-сервера и 0,13 ГВтч для обучения одной LLM обойдутся в 400 тыс. долл.

«Нам нужны плотные компьютеры, а не большие», — сказал Хуанг.

Дата-центры будут наращивать мощности

Конечно, распределение вычислений может обеспечить обучение LLM без использования ускоренных вычислений. Но, считает Хуанг, строить больше дата-центров слишком дорого. По его прогнозам, существующие дата-центры будут усилены серверами для ускоренных вычислений.

«Заставьте каждый ЦОД работать больше, — призывает он. — Сегодня почти все они ограничены в мощности».

Описанные им тенденции набирают обороты. «Использование графических процессоров настолько высоко, что почти каждый ЦОД перенапряжен, так много различных приложений задействуют их», — сказал Хуанг. Он видит спрос на запущенный в серийное производство ИИ-чип Nvidia H100 стоимостью 200 тыс. долл. «буквально во всех уголках мира».

Больше, чем цифры и слова

Впервые в истории компьютеры могут понимать не только цифры и слова, сказал Хуанг.

«У нас есть программная технология, которая может понимать мультимодальное представление. Мы можем применять этот инструмент компьютерной науки в столь многих областях, что раньше казалось невозможным», — отметил он.

Компьютеры теперь могут изучать язык структуры многих вещей. Эта возможность появилась, когда неконтролируемое обучение с помощью трансформеров научилось предсказывать следующее слово. Таким образом, были созданы LLM, сказал Хуанг.

После того как компьютер выучит язык какой-то области, пользователь может направлять ИИ с помощью подсказок на генерацию новой информации любого рода, отметил Хуанг. Благодаря этому стало возможным преобразование одного вида информации в другой, например, текста в изображение, текста в белок, текста в музыку и т. п.

Между тем, добавил он, барьер для вычислений сейчас «невероятно низок». Как может подтвердить любой пользователь ChatGPT, для создания контента можно использовать текстовую подсказку. «Мы преодолели цифровой разрыв. Теперь каждый человек — программист. Вам просто нужно сказать что-то компьютеру, — пояснил Хуанг. — Это настолько просто в использовании, что затронуло все отрасли».

Более того, по его словам, ИИ может сделать удивительные вещи для каждого отдельного приложения из предыдущей эпохи. «Каждое существующее приложение станет лучше благодаря ИИ. Этой вычислительной эре не нужны новые приложения; она может преуспеть со старыми приложениями», — считает он.

Именно поэтому генеративный ИИ включается в существующие пакеты продуктов многих компаний.

Новый подход к вычислениям

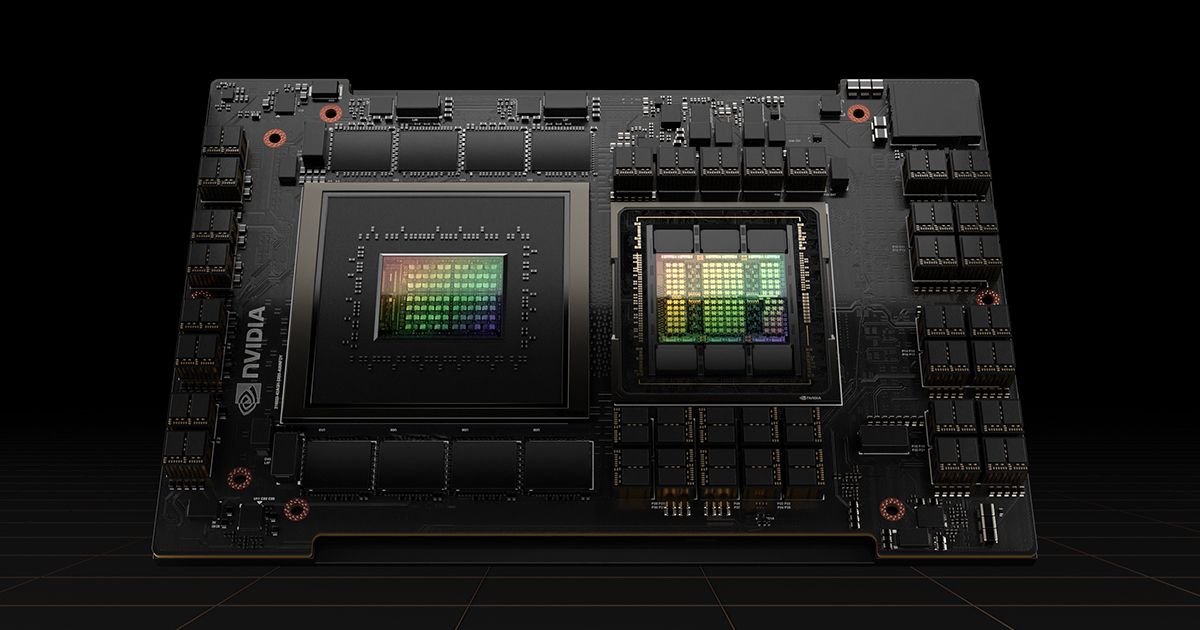

Но ИИ нужен новый подход к вычислениям: ускоренные вычисления, созданные с нуля. Для этой цели служит суперчип Grace Hopper, который объединяет архитектуры Grace CPU и Hopper GPU на базе Arm с использованием технологии межсоединения NVLink-C2C. Пропускная способность в 900 Гб/с обеспечивает высокоскоростную связь между чипами. По словам Хуанга, GPU и CPU могут обращаться к единой памяти, что позволяет избежать ненужного копирования. Промышленное производство Grace Hopper уже полностью развернуто.

Хуанг продемонстрировал новый ИИ-суперкомпьютер DGX GH200, поддерживающий языковые модели с триллионами параметров. Он объединяет 256 суперчипов Grace Hopper, которые работают как один «массивный» GPU, позволяя разрабатывать «гигантские» модели для языковых приложений генеративного ИИ, систем рекомендаций и рабочих нагрузок аналитики данных. Суперкомпьютер располагает 144 Тб общей памяти и обеспечивает производительность в 1 эксафлопс.