Центры обработки данных сталкиваются с кризисом из-за роста применения специализированных чипов искусственного интеллекта, потребляющих непомерное количество энергии. Реконфигурируемые вычисления (reconfigurable computing) представляют собой лучший выход из этой ситуации, пишет на портале Data Center Knowledge Элад Раз, генеральный директор компании NextSilicon.

ИИ и высокопроизводительные вычисления (HPC) вступили в новую фазу внедрения, глубоко преобразуя отрасли, ускоряя инновации и расширяя границы возможного. Дата-центры стремятся приспособиться к этим меняющимся рабочим нагрузкам, добавляя различные ускорители в свои существующие среды, однако эта благонамеренная гетерогенность наносит ущерб операционной эффективности.

Стратегия сочетания специализированных чипов с CPU, GPU и системами на базе ASIC приводит к беспрецедентной сложности. Она повышает энергопотребление до неустойчивого уровня и добавляет операционные накладные расходы, которые угрожают подорвать потенциальные выгоды.

По мере того как границы между рабочими нагрузками и рабочими процессами становятся все более размытыми, а модели становятся слишком большими для отдельных ускорителей, задача эксплуатации дата-центров и «сопоставления узлов» — сопряжения систем с необходимой производительностью, эффективностью и экономичностью для конкретных рабочих нагрузок — становится все более сложной.

Чтобы выйти из этой спирали операционной сложности, операторы должны сначала понять, что вызывает эти проблемы, прежде чем принимать решение о новом пути развития.

Новые методологии и законы масштабирования

Сегодняшние рабочие нагрузки радикально отличаются от тех, что были всего несколько лет назад, когда границы между инфраструктурой обучения и инфраструктурой вывода были более четкими и различимыми. Появление трансформерных архитектур, «смеси экспертов» (MoE) и агентных систем ИИ перевернуло эти простые определения с ног на голову.

Эти новые методы кардинально изменили шаблоны вычислений, потребовав частых, ресурсоемких циклов ИИ-вывода — иногда в 100 раз более требовательных, чем традиционный однопроходный вывод. Масштаб моделей достиг критической точки перегиба, когда их необходимо распределять по нескольким устройствам, что коренным образом меняет потребности инфраструктуры.

Кроме того, рабочие нагрузки ИИ теперь охватывают три различных парадигмы масштабирования: базовое предварительное обучение, при котором больше данных и параметров повышают точность; итеративное последующее обучение для оптимизации эффективности и доработки с учетом специфики конкретной области; и вычислительно-интенсивное масштабирование во время тестирования, которое позволяет выполнять сложные многоэтапные рассуждения.

Эта эволюция означает, что современное получение выводов быстро стирает границы между традиционными требованиями к инфраструктурам обучения и вывода, что приводит к дальнейшему росту сложности и вычислительных требований к дата-центрам.

Традиционные GPU-ориентированные дизайны с трудом удовлетворяют этим требованиям, но рефлекторная реакция отрасли, заключающаяся в добавлении более специализированных ускорителей, может создать еще большую проблему.

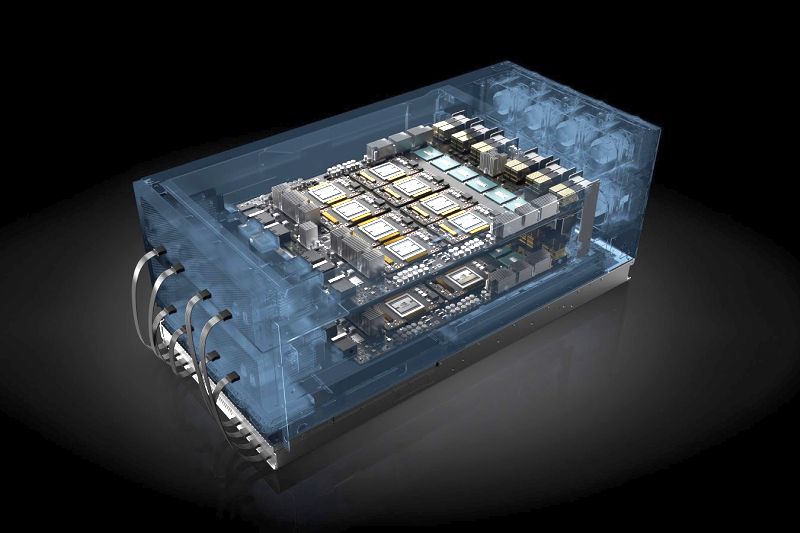

Современные ускорители, потребляющие от 1400 до 2000 Вт на устройство, создают плотность стоек порядка 600 кВт, что превышает возможности более 75% дата-центров

Это приводит к огромным затратам на электроэнергию: один дата-центр Stargate Project требует 1,21 ГВт, что эквивалентно энергопотреблению среднего города в США.

Не менее тревожным является взрывной рост операционной сложности. Каждый новый тип ускорителя вводит новые пространства памяти, стеки драйверов и потенциальные точки отказа. Представьте себе конвейер ИИ, распределенный по четырем типам устройств, требующий управления четырьмя различными протоколами когерентности памяти, четырех или более стандартов межсоединений и четырех отдельных сред разработки, специфичных для каждого поставщика. Каждый добавленный тип чипа становится потенциальной точкой отказа или узким местом, если им не управлять профессионально.

Эти операционные сложности приводят к неустойчивой экономической ситуации. Заказные ASIC, специализированные чипы и выделенные процессоры обещают повышение производительности, но требуют дополнительного пространства, инфраструктуры охлаждения и опыта интеграции. Такой подход «один чип на одну задачу» напоминает коллекционирование роскошных яхт — впечатляюще в отдельности, но непомерно дорого в обслуживании и эксплуатации в больших масштабах.

Тем не менее, отрасль продолжает идти по этому пути, движимая, по-видимому, непреодолимой задачей: необходимостью сопоставить все более сложные рабочие нагрузки с оптимальными аппаратными ресурсами.

Дилемма оптимизации

Сами модели ИИ также быстро развиваются, основываясь на этой потребности в гетерогенности. По мере того как модели растут в размерах и сложности в геометрической прогрессии, они все больше полагаются на шардинг — разбиение моделей или рабочих нагрузок на более мелкие, распределенные части — для эффективного масштабирования. Эта фрагментация создает еще одну проблему: интеллектуальное сопоставление этих фрагментированных рабочих нагрузок с оптимальными аппаратными ресурсами.

Эффективное сопоставление узлов — соединение конкретных фрагментов рабочей нагрузки с идеальными вычислительными ресурсами — становится критически важным для оптимизации производительности, экономичности и эффективности всего дата-центра. Традиционные статические назначения аппаратных ресурсов являются неадекватными, поскольку характеристики рабочей нагрузки могут значительно варьироваться. Некоторые фрагменты могут быть вычислительно-интенсивными и требовать большой вычислительной мощности, в то время как другие могут быть ограничены пропускной способностью памяти или требовать специальных возможностей межсоединения.

Эта проблема заставила отрасль искать все более сложные гетерогенные решения, но есть и более элегантная альтернатива. Вместо того чтобы координировать работу нескольких специализированных чипов, что если бы одна перенастраиваемая платформа могла адаптировать свою архитектуру для динамического удовлетворения этих меняющихся требований?

Революция реконфигурируемости: один чип, множество возможностей

Индустрия дата-центров находится на перепутье. Текущий путь — накопление специализированных ускорителей — ведет к неустойчивости из-за роста сложности и энергопотребления.

Альтернативный подход сосредоточен на интеллектуальной реконфигурируемости: аппаратное обеспечение, которое динамически адаптирует свою архитектуру к требованиям рабочей нагрузки в режиме реального времени. Рассмотрим фундаментальное отличие: вместо поддержания отдельных чипов для векторных операций, тензорных вычислений и задач, требующих интенсивного использования памяти, реконфигурируемые ускорители могут изменять свои пути передачи данных, иерархии памяти и блоки выполнения за наносекунды. Это устраняет накладные расходы на миграцию данных между различными типами процессоров, сохраняя при этом преимущества специализированного оборудования в плане производительности.

Реконфигурируемые системы предлагают убедительные преимущества по сравнению с архитектурами с фиксированными функциями. Они устраняют узкие места в межчиповой коммуникации, сохраняя данные локально в вычислительной структуре. Они снижают энергопотребление, избегая неэффективности извлечения инструкций из памяти, присущей архитектурам фон Неймана. Что наиболее важно, они обеспечивают программную совместимость с такими фреймворками, как CUDA и OpenCL, что позволяет развертывать их без дорогостоящей переработки приложений.

Такой подход превращает задачу сопоставления узлов из сложной проблемы оркестрации в автоматизированный процесс оптимизации. Вместо того чтобы вручную распределять фрагменты рабочей нагрузки по разрозненным аппаратным ресурсам, интеллектуальные перенастраиваемые системы анализируют характеристики ядра и автоматически настраивают оптимальные среды выполнения.

От сложности к настраиваемости: интеллектуальная вычислительная архитектура

Эффективное сопоставление узлов представляет собой комплексную задачу для дата-центров, требующую решений на всех уровнях технологического стека. Это касается как низкоуровневых межсоединений и иерархий памяти, так и вычислительных систем и сложного ПО для оркестрации.

Эта многомерная задача требует нового подхода в дата-центрах, где сосуществует широкий спектр традиционных процессоров, графических процессоров, ASIC и специализированных ускорителей.

Хотя разнообразие ускорителей является реальностью сегодняшнего дня, отрасль должна развиваться в направлении интеллектуальных, программно-определяемых решений для аппаратного ускорения, способных динамически адаптироваться к разнообразным рабочим нагрузкам. Будущие ускорители и системы должны непрерывно анализировать характеристики рабочей нагрузки и динамически оптимизировать выполнение. Такой подход устраняет сложную ручную оркестрацию, которая обычно требуется для разнородных компонентов.

Такие интеллектуальные решения предлагают организациям неоспоримые преимущества по сравнению с традиционными архитектурами: беспрецедентную эффективность, масштабируемую производительность и простоту эксплуатации. Они должны легко интегрироваться в существующие инфраструктуры в качестве «быстрых» заменителей, позволяя избежать дорогостоящих работ по перепроектированию ПО. Кроме того, интеллектуальные аппаратные конструкции обеспечивают готовность к будущему, поддерживая модели и алгоритмы ИИ завтрашнего дня, даже те, которые еще не разработаны, обеспечивая дата-центрам надежную долгосрочную актуальность.

Адаптивное, эффективное и интеллектуальное будущее

Дата-центры будущего должны выбрать между двумя принципиально разными путями: продолжить движение по пути гетерогенной сложности или принять интеллектуальную реконфигурируемость. Текущий подход, заключающийся в накоплении специализированных ускорителей, создает сложность эксплуатации, неустойчивое энергопотребление и проблемы интеграции, которые часто нивелируют преимущества в производительности.

Более устойчивой альтернативой являются системы, учитывающие рабочую нагрузку, которые могут перенастраиваться в режиме реального времени в соответствии с требованиями ИИ, HPC и других технологий. Объединяя несколько вычислительных характеристик в адаптивное программно-определяемое оборудование, дата-центры могут достичь настоящей эффективности за счет устранения накладных расходов между чипами, высокой производительности за счет мгновенной оптимизации микроархитектуры и простоты эксплуатации за счет более унифицированного оборудования и ПО.

Отрасль достигла переломного момента, когда традиционная формула «больше чипов для большей производительности» больше не работает. Успех в следующем поколении дата-центров будет принадлежать организациям, которые признают интеллектуальную реконфигурируемость как путь выхода из этой спирали сложности. С появлением новых дата-центров, требующих 1,21 ГВт энергии, мы должны двигаться к более эффективному будущему, а не к операционному хаосу.