Выступая на прошлогодней конференции HPE Discover Virtual Experience президент и генеральный директор компании HPE Антонио Нери отметил, что несмотря на очевидные достоинства и растущую популярность облаков, по-прежнему 70% корпоративных приложений и данных находятся не в облаке, а в ЦОДах компаний. Причин этого явления несколько: сложность обеспечения безопасности в облаке, недостаточная производительность, высокие затраты, неполный контроль. Проблема также в том, что традиционные архитектуры плохо стыкуются с облачными. Сложно оперативно перемещать ИТ-ресурсы между публичными облаками разных провайдеров и между облаком и онпремисной системой.

Быстро увеличивается доля данных, генерируемых и обрабатываемых вне ЦОДов и облаков на периферии сети. Согласно прогнозу Gartner, эта доля вырастет с 10% в 2018 г. до 75% в

Для реализации этой стратегии компания предложила платформу HPE GreenLake, облачные сервисы которой охватывают управление контейнерами, операции машинного обучения, виртуальные машины, вычислительную обработку, а также защиту данных и сети. В начале мая 2021 г. компания расширила GreenLake, представив новую платформу сервисов для работы с данными по модели Storage-as-a-Service, призванную ответить на взрывной рост объемов данных, генерируемых повсюду — от периферийных сегментов до облака, и ускорить проекты цифровой трансформации своих клиентов. Утверждается, что благодаря этому HPE Storage — один из крупнейших бизнесов компании, трансформируется в облачное подразделение, предоставляющее программно-определяемые услуги по работе с данными, призванные ускорить получение клиентами реальной отдачи от накапливаемой ими информации.

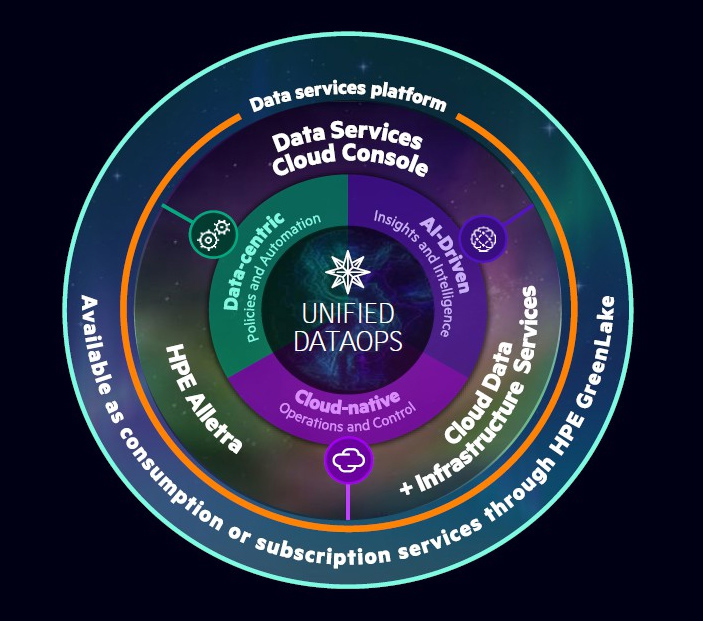

Представленная платформа реализует концепцию нового опыта работы с данными Unified DataOps, предполагающую применение облачной модели независимо от того, где реально размещены данные, и унифицирующую все операции по работе с ними. Новая платформа призвана решить проблемы взрывного роста объемов данных во всех сегментах — от периферии до облака, справиться с разрозненностью и сложностью современных сред хранения данных, обеспечить их максимальную гибкость и готовность к инновациям, а также снизить бизнес-риски.Сегодня организациям приходится бороться со сложностью информационных систем. Согласно исследованию, посвященному управлению данными, проведенного для HPE компанией ESG, 93% отвечающих за ИТ руководителей считают, что цифровой трансформации препятствует сложность хранения и управления данными, а 67% опрошенных организаций полагают, что фрагментированное представление данных в гибридном облаке создает риски для бизнеса. Предлагаемая HPE концепция нового подхода к работе с данными Unified DataOps объединяет политики, ориентированные на данные, облачные методы управления и применение средств ИИ для управления данными и инфраструктурой в условиях разнородности и сложности сред хранения, повышение операционной гибкости во всех сегментах от периферии до облака, минимизацию бизнес-рисков и ускорение инноваций, основанных на данных.

«HPE меняет подход к хранению данных, предлагая клиентам полную модель облачных операций в их локальных средах, — заявил генеральный директор подразделения HPE Storage Том Блэк. — Перенос облачной операционной модели туда, где реально располагаются данные, ускорит цифровую трансформацию, оптимизирует управление данными и поможет нашим клиентам внедрять инновации быстрее, чем когда-либо прежде».

Основные элементы анонсированной платформы — это новая консоль Data Services Cloud Console, облачные сервисы по управлению данными и новая облачная инфраструктура хранения данных на базе СХД HPE Alletra.

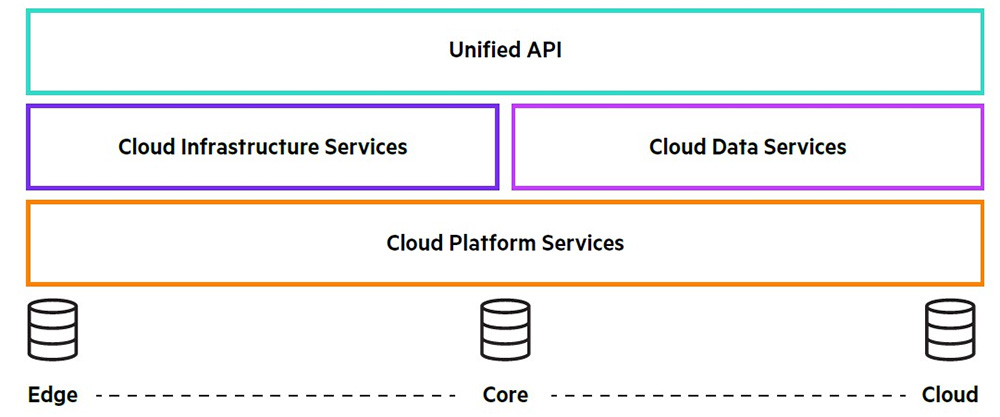

Data Services Cloud Console реализует облачные и унифицированные операции с данными, предоставляемыми как услуга. Она основана на апробированной, безопасной, нативной облачной технологии, которая лежит в основе Aruba Central — инструмента, обслуживающего миллионы устройств, подключенных десятками тысяч клиентов в кластерах, развернутых по всему миру. Консоль предлагает унифицированные API для автоматизации приложений под контролем HPE, партнерских и пользовательских служб данных, а также предоставляет разработчикам доступ к инфраструктуре и данным через программный код. Реализованная в ней возможность простого и не затратного перемещения онпремисных данных и приложений в облако и обратно поможет выбирать наиболее эффективные с точки зрения бизнеса решения. Аналогичные возможности в плане гибкой мобильности данных предоставляются и для мультиоблачных сред.

В рамках Data Services Cloud Console компания предоставляет Data Ops Manager — средство для глобального управления инфраструктурой хранения данных из любого места и с любого устройства, а также выделения ресурсов на основе предполагаемых шаблонов использования. Это меняет парадигму инициализации инфраструктуры данных с помощью подхода, основанного на ИИ и ориентированного на приложения, который обеспечивает самообслуживание, инициализацию по требованию, избавляет от необходимости строить догадки и оптимизирует целевые показатели уровня обслуживания (SLO). Как утверждают в HPE, применение инструментов ИИ для прогнозирования и быстрого выявления первопричин сбоев позволяет на 73% уменьшить число регистрируемых инцидентов, на 85% меньше времени тратить на диагностику и на 69% ускорить восстановление системы службами техподдержки третьего уровня.HPE Alletra — это СХД для облачной инфраструктуры хранения, которая поддерживает технологию All-NVMe и обеспечивает работу с данными повсюду — от периферийных сегментов до облака. Она представлена семейством систем Alletra 9000 и 6000, обеспечивающих архитектурную гибкость для запуска любых приложений без каких-либо ограничений. Они позволят в широких пределах консолидировать традиционные и современные критически важные рабочие нагрузки. Модель Alletra 9000 в корпусе высотой 4U обеспечивает удельную производительность более 2 млн. IOPS. Ее работа проверена на

Опираясь на технологии ИИ и МО система HPE InfoSight способна предсказывать и предотвращать сбои в работе СХД, серверов и виртуальных машин. С помощью HPE Alletra и HPE Cloud Volumes клиенты могут начать разработку/тестирование в облаке, а когда будут готовы запустить приложение в производственную эксплуатацию, то, если это необходимо для лучшего контроля затрат, управления данными, применения VDI и т. д., без проблем вернут его обратно в онпремисную среду. То же самое касается приложения, созданного в облаке — можно вернуть его в свой ЦОД и продолжать использовать в облачной парадигме, не прибегая к сложному рефакторингу данных.

Как Alletra впишется в модельный ряд СХД HPE? Отвечая на этот вопрос, Том Блэк сказал, что Alletra базируется на технологиях, разработанных ранее для СХД HPE Primera и Nimble и расширяет их облачные возможности. Предполагается, что в конце нынешнего года заинтересованным заказчикам, уже эксплуатирующим указанные СХД, будет предложен апгрейд на системы Alletra. В то же время, HPE не намерена прекращать развитие линеек Primera и Nimble.