Руководитель направления ответственного ИИ в Accenture Рэй Эйтель-Портер поделился с порталом AI Business результатами недавнего исследовании компании.

Сегодня компании гораздо лучше осведомлены о предстоящем регулировании в области ИИ, чем до вступления в силу в 2018 г. жестких европейских правил защиты данных и конфиденциальности GDPR. Но они все еще далеко не готовы к этому, говорится в новом отчете Accenture.

Согласно опросу 850 руководителей высшего звена в 17 географических регионах в 20 отраслях, большинство компаний осознают важность ответственного использования ИИ, однако «многие из них находятся на том этапе, когда они приняли ряд принципов, но еще не смогли внедрить их в масштабах предприятия», — сообщил Эйтель-Портер. По его словам, время действовать пришло, поскольку внедрение эффективной системы в масштабах предприятия может занять годы, а не месяцы.

Хорошей новостью является то, что 80% компаний выделили 10% своего ИИ-бюджета на ответственный ИИ, а 45% выделили 20%. «Это очень серьезное обязательство», — отметил Эйтель-Портер.

По его словам, важно, что компаниям, уже имеющим систему управления рисками, не нужно начинать с нуля, чтобы создать ответственный ИИ.

Установление порога предвзятости

Ответственный ИИ — это практика проектирования и разработки моделей ИИ, которая является этичной и поддерживает принципы, которыми дорожат организации и общество. В то время как различные организации могут иметь различия в основных ценностях, общество, как правило, имеет «довольно сильное» общее мнение о том, что является этичным и ориентированным на человека способом использования ИИ, сказал Эйтель-Портер.

Примечательно, что ответственный ИИ требует участия всего предприятия. Это не только для технологов. Почему? Несмотря на то, что специалисты в области науки о данных действительно выполняют большую работу по подготовке данных для обучения моделей, есть вопросы, на которые может ответить только бизнес, пояснил Эйтель-Портер.

Один из примеров — установление минимального порога необъективности, с которым можно мириться. 10%? 15%? 20%? Где установить порог предвзятости — или ошибки — это решение бизнеса.

Интуиция большинства людей подсказывает, что предвзятости быть не должно вообще. Но это может привести к неточным результатам. «В большинстве случаев существует компромисс между точностью и предвзятостью, — сказал Эйтель-Портер. — Если мы уберем все предубеждения, мы очень часто будем иметь неточный прогноз».

Рассмотрим некую Джилл, у которой низкий кредитный рейтинг, потому что у нее были проблемы с погашением кредитов или своевременными платежами. Она подает заявку на кредит, и при прочих равных условиях это означает, что существует большая вероятность того, что она снова не сможет его погасить или просрочит платежи. Если поставить Джилл в равные условия с Мэри, у которой высокий кредитный рейтинг — нулевая предвзятость при прочих равных условиях — это может привести к неверному прогнозу о том, будет ли Джилл выплачивать кредит.

Устранение пробелов в наборе данных

После определения порога ошибки модель ИИ тестируется на исторических данных. Набор данных, содержащий всех клиентов компании, разбивается на группы, и модель применяется. Коэффициент ошибок должен быть одинаковым для всех групп. Если в одной группе этот показатель выше, чем в других, то «математически наша модель работает не так хорошо в этой группе», — пояснил Эйтель-Портер.

Но одной из проблем при тестировании моделей ИИ на предвзятость являются пробелы в наборе данных. Например, банк может захотеть проверить, дискриминирует ли его модель ИИ представителей определенной этнической группы. Но в его внутренней базе данных нет информации об этнической принадлежности, поскольку он не запрашивал ее у владельцев счетов. Таким образом, банк не может проверить наличие предвзятости, используя свой собственный набор данных.

Схема Accenture

Многие компании могут сформулировать свои основные принципы и перечислить их на своих веб-сайтах, но «это не означает, что кто-то что-то делает в соответствии с ними», — сказал Эйтель-Портер. Только система управления может гарантировать, что люди будут соблюдать эти принципы.

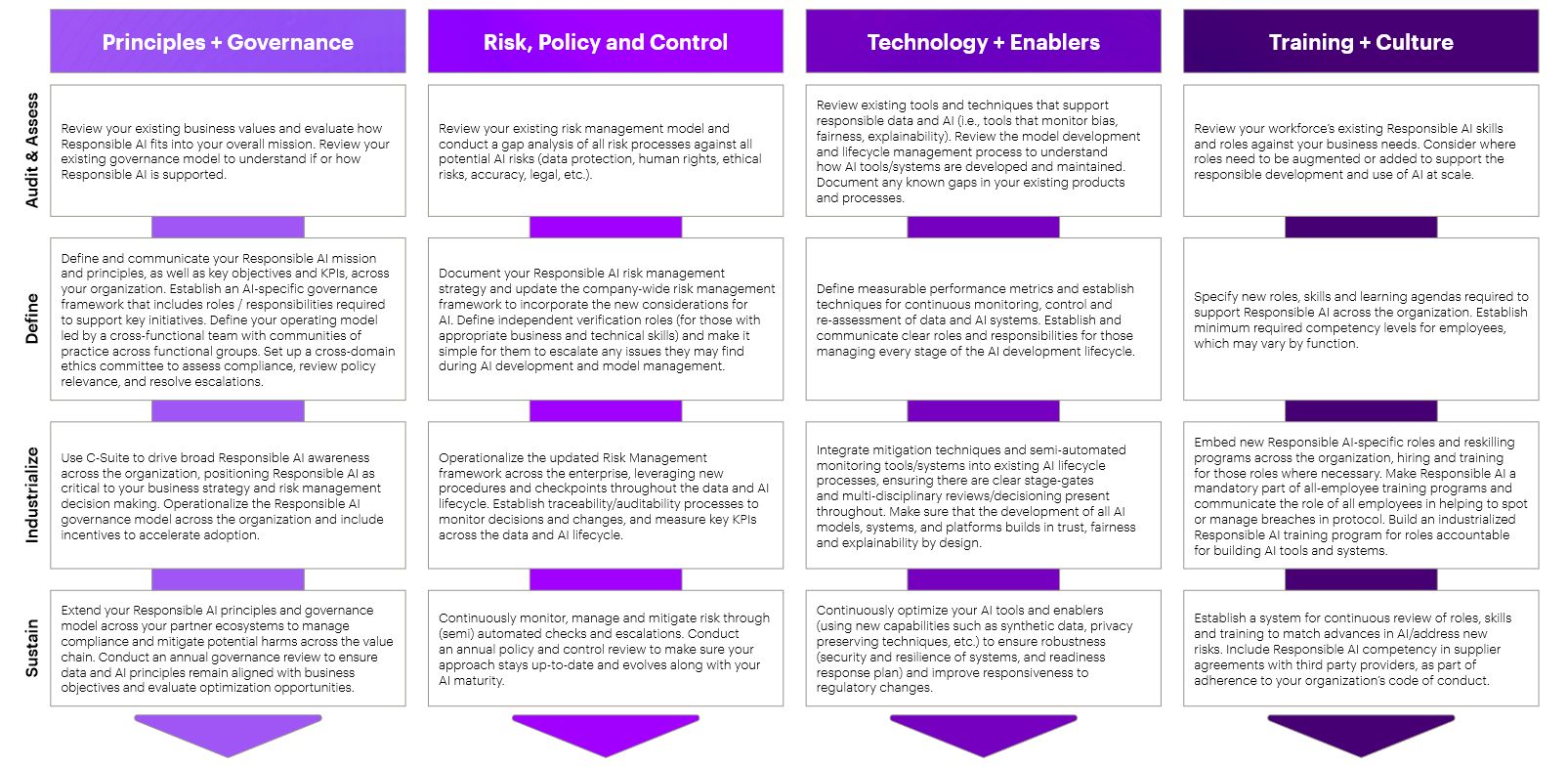

Ниже представлена предлагаемая Accenture схема для разработки ответственного ИИ.

По словам Эйтель-Портера, четырьмя столпами внедрения ответственного ИИ являются следующие горизонтальные категории: 1) принципы и управление (Principles and Governance); 2) риски, политика и контроль (Risk, Policy and Control); 3) технологии и вспомогательные средства (Technology and Enablers); 4) обучение и культура (Training and Culture).

Шаги из первой категории помогут сформулировать основные представления. Действия из второй позволят заставить людей придерживаться этих принципов, определив контрольные точки и обеспечив соответствие нормативным требованиям.

Чтобы внедрение было успешным, надо следовать наставлениям, описанным в третьей категории. По словам Эйтель-Портер, специалисты в области науки о данных в компании должны иметь опыт и подготовку по темам, связанным с ответственным ИИ, таким как избежание предвзятости. Сторонние инструменты также доступны у гиперскейлеров и крупных облачных провайдеров, а также у вендоров и на Open Source-ресурсах.

Четвертый столп определяет, как компания следит за тем, чтобы сотрудники всех отделов, будь то служба поддержки клиентов, юридический отдел, отдел кадров или другое подразделение, понимали, что они являются частью решения.

Вертикальные категории — аудит и оценка (Audit and Assess), определение (Define), индустриализация (Industrialize), поддержка (Sustain) — помогают компаниям понять, на каком этапе процесса они находятся, что еще необходимо сделать, как заполнить существующие пробелы и как поддерживать систему.