Авторы недавно опубликованного исследования очень конкретно определили, что на самом деле представляет собой «цепочка мыслей» («chain of thought», CoT) большой языковой модели (LLM), сообщает портал ZDNet.

С тех пор, как программы искусственного интеллекта начали впечатлять широкую публику, ученые, занимающиеся ИИ, заявляют о более глубоком значении этой технологии, даже утверждая, что она может достичь уровня понимания, подобного человеческому. Однако они лишь «философствуют», потому что даже те, кто создает модели ИИ, такие как GPT-5 от OpenAI, не до конца понимают, как работают эти программы.

«Черный ящик» ИИ и машина ажиотажа

ИИ-программы, такие как LLM, известны как «черные ящики». Они достигают впечатляющих результатов, но в большинстве случаев мы не можем видеть все, что они делают, когда принимают входные данные, такие как введенный вами запрос, и выдают результат, такой как заказанная вами курсовая работа или предложение для вашего нового романа.

В связи с этим для описания работы этих программ ученые стали использовать разговорные термины, такие как «рассуждение» («reasoning»). При этом они либо подразумевают, либо прямо утверждают, что программы могут «думать», «рассуждать» и «знать» так же, как люди.

За последние два года риторика обогнала науку, поскольку руководители компаний, занимающихся ИИ, использовали гиперболы, чтобы преувеличить простые инженерные достижения.

В пресс-релизе OpenAI, опубликованном в сентябре прошлого года, в котором была анонсирована модель рассуждений o1, говорилось, что «подобно тому, как человек может долго думать, прежде чем ответить на сложный вопрос, o1 использует цепочку мыслей при попытке решить проблему», так что «o1 учится оттачивать свою цепочку мыслей и совершенствовать используемые стратегии».

От этих антропоморфных утверждений был всего один шаг до всевозможных смелых заявлений, таких как комментарий генерального директора OpenAI Сэма Альтмана в июне: «Мы прошли горизонт событий; взлет начался. Человечество близится к созданию цифрового сверхинтеллекта».

Негативная реакция исследователей ИИ

Однако со стороны ученых, занимающихся ИИ, наблюдается негативная реакция, они опровергают предположения о создании человекоподобного интеллекта посредством тщательного технического анализа.

Чэншуай Чжао и его коллеги из Университета штата Аризона разбили аргументы в пользу «рассуждений» ИИ с помощью простого эксперимента. Они пришли к выводу, что «цепочка мыслительных выводов — это хрупкая иллюзия» и что она «не является механизмом подлинного логического вывода, а скорее сложной формой структурированного сопоставления шаблонов».

Термин CoT обычно используется для описания подробного потока вывода, который вы видите, когда большая модель рассуждений, такая как GPT-o1 или DeepSeek V1, показывает вам, как она решает задачу, прежде чем дать окончательный ответ.

Этот поток утверждений не так глубок и значим, как кажется, утверждают Чжао и его команда. «Эмпирические успехи CoT-рассуждений приводят к представлению, что LLM участвуют в целенаправленных процессах вывода», — пишут они.

Однако «растущее число анализов показывает, что LLM, как правило, полагаются на поверхностную семантику и подсказки, а не на логические процедуры, — объясняют авторы. — LLM строят поверхностные цепочки логики на основе выученных ассоциаций токенов, часто терпя неудачу в задачах, которые отклоняются от здравого смысла или знакомых шаблонов».

Термин «цепочки токенов» — это распространенный способ обозначения ряда элементов, вводимых в LLM, таких как слова или символы.

Проверка того, что на самом деле делают LLM

Чтобы проверить гипотезу о том, что LLM просто сопоставляют шаблоны, а не действительно рассуждают, исследователи обучили старую (от 2019 г.) открытую LLM OpenAI GPT-2, начиная с нуля, используя подход, который они называют «алхимией данных».

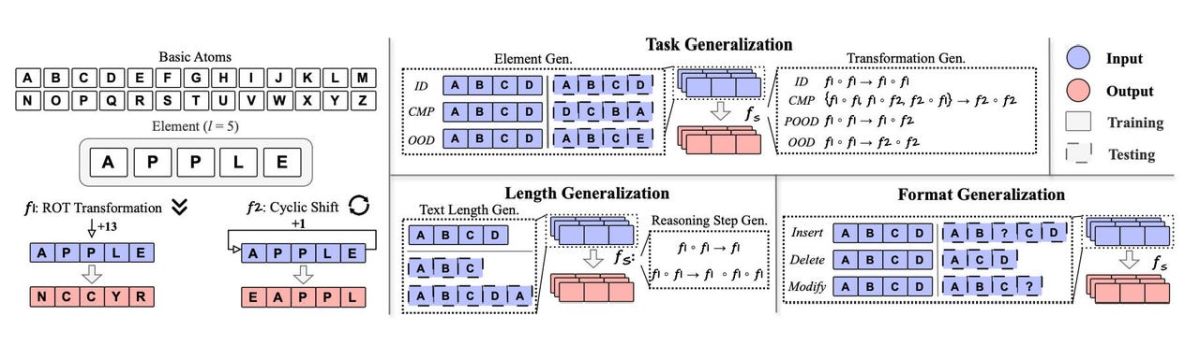

Модель с самого начала была обучена манипулировать только 26 буквами английского алфавита: A, B, C... и т. д. Это упрощенный корпус позволил Чжао и его команде протестировать LLM с помощью набора очень простых задач. Все задачи включают манипулирование последовательностями букв, например, сдвиг каждой буквы на определенное количество позиций, так что «APPLE» становится «EAPPL».

Используя ограниченное количество токенов и ограниченное количество задач, исследователи варьировали задачи, которые языковая модель выполняет на своих обучающих данных, а также задачи, которые появляются только при тестировании готовой модели, например, «Сдвинуть каждый элемент на 13 позиций». Это проверка того, способна ли языковая модель логически обосновать способ выполнения при столкновении с новыми, ранее не встречавшимися задачами.

Они обнаружили, что если задачи не было при обучении, языковая модель не могла правильно ее выполнить, используя цепочку мыслей. Модель пыталась использовать задачи, которые были в ее обучающих данных, и ее «рассуждения» звучали убедительно, но полученный ею ответ был неправильным.

Как пишут авторы, «LLM пытаются обобщить пути рассуждений на основе наиболее похожих [...] виденных во время обучения, что приводит к правильным путям рассуждений, но неправильным ответам».

Специфика противодействия ажиотажу

Авторы делают несколько выводов.

Во-первых: «Остерегайтесь чрезмерной зависимости и ложной уверенности», советуют они, потому что «способность LLM „бегло генерировать бессмыслицу“ — правдоподобные, но логически несостоятельные цепочки рассуждений — может быть более обманчивой и вредной, чем откровенно неправильный ответ, поскольку она создает ложную ауру надежности».

Кроме того, попробуйте выполнить задачи, которые явно не могли быть включены в обучающие данные, чтобы подвергнуть модель ИИ стресс-тестированию.

Важность подхода Чжао и его команды заключается в том, что они выступают против каких-либо вымыслов и преувеличений и возвращают нас к основам понимания того, что именно делает ИИ.

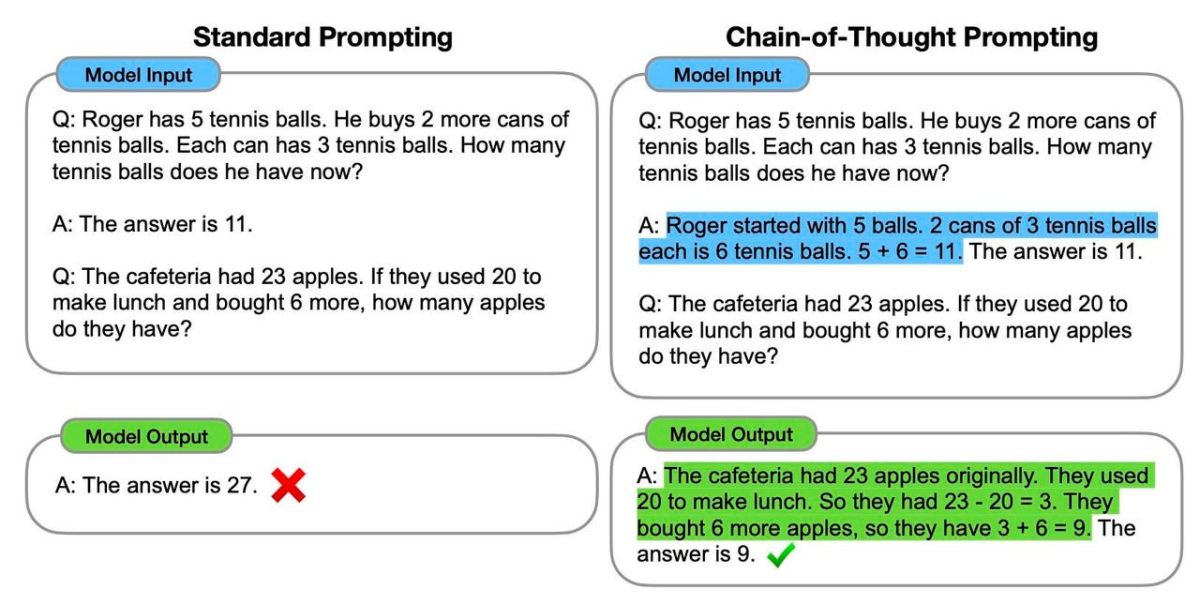

Когда в 2022 г. Джейсон Вэй и его коллеги из команды Google Brain провели первоначальное исследование по цепочке мыслей «Chain-of-Thought Prompting Elicits Reasoning in Large Language Models», которое с тех пор было процитировано более 10 тыс раз, они не сделали в нем никаких заявлений относительно реальности рассуждений ИИ.

Вэй и его команда заметили, что подсказка LLM перечислить шаги в решении задачи, такой как арифметическая задача «Если в банке 10 печенек, и Салли вынимает одно, сколько останется в банке?», в среднем приводила к более правильным ответам.

Они были осторожны и не утверждали, что система может обладать способностями, подобными человеческим. «Хотя цепочка мыслей имитирует процессы мышления человека, это не дает ответа на вопрос, действительно ли нейронная сеть „мыслит“, и мы оставляем этот вопрос открытым», — писали они в то время.

С тех пор в заявлениях Альтмана и различных пресс-релизах промоутеров ИИ все чаще подчеркивается человекоподобный характер мышления, при этом используется небрежная и неточная риторика, которая не учитывает чисто техническое описание Вэя и его команды.

Работа Чжао и его команды напоминает нам о том, что мы должны быть конкретными, а не суеверными в отношении того, что на самом деле делает машина, и избегать гиперболических заявлений.