Обработка естественного языка (natural language processing, NLP) — это подмножество искусственного интеллекта, на котором работают голосовые боты и текстовая аналитика. Портал EnterpriseAI приводит рассуждения технического директора и основателя поставщика ИИ- и NLP-решений в сфере здравоохранения John Snow Labs Дэвида Талби о том, где эта технология уже применяется, ее проблемах и перспективах.

Несмотря на то, что бюджеты на NLP на многих предприятиях продолжают расти, эта технология все еще нуждается в критически важных усовершенствованиях, которые повысят ее точность и облегчат ее использование для широкого спектра бизнес-проектов сотрудниками, не обладающими навыками работы с данными. Таковы некоторые выводы нового исследования «2021 NLP Industry Survey, Insights and Trends: How Companies Are Using Natural Language Processing», которое по заказу John Snow Labs провела компания Gradient Flow, занимающаяся аналитикой данных и инсайтами.

NLP — это ИИ-дисциплина, которая обучает машины распознавать человеческий язык и превращать его в полезные данные, которые можно использовать для решения множества задач. Согласно отчету, 60% из 655 респондентов заявили, что их бюджеты на NLP в 2021 г. вырастут как минимум на 10%, тогда как еще 33% решили увеличить их на 30%. При этом 15% респондентов в течение года более чем в два раза увеличили бюджеты на эту технологию.

На вопрос об основных аспектах применения NLP 40% респондентов ответили, что наиболее важным требованием при оценке продуктов NLP является точность их работы. 24% отметили, что наиболее важным требованием является готовность к коммерческой эксплуатации, в то время как 16% ищут качественную масштабируемость. 39% респондентов заявили, что испытывают трудности с настройкой моделей NLP, а 36% посетовали на стоимость технологии.

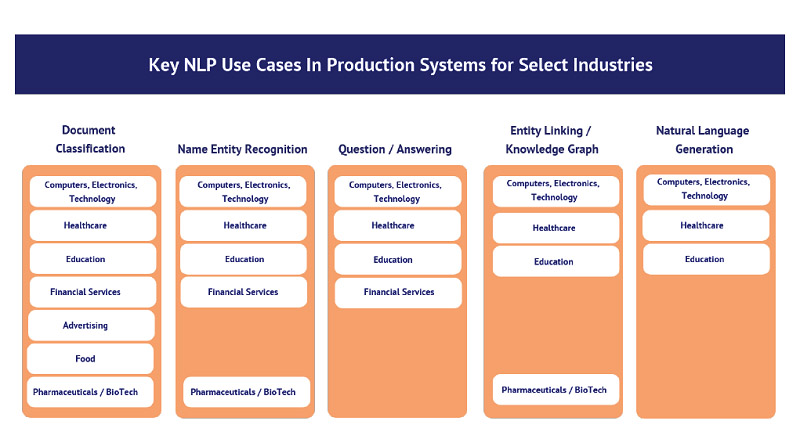

В четверку ведущих отраслей, задействующих NLP, вошли здравоохранение — 17%, технологии — 16%, образование — 15% и финансовые услуги — 7%. Дэвид Талби считает, что решение этих проблем и требований клиентов — важная задача с точки зрения развития рынка. Комментарии респондентов опроса свидетельствуют о том, что системы NLP требуют доработки, чтобы упростить для пользователей настройку моделей или возможность создания эффективного конвейера, чтобы их можно было разворачивать в масштабе.

«Я считаю, что проблемы, связанные с точностью, обычно возникают тогда, когда люди пропускают шаги, которые необходимы на этапе настройки. Вместо этого компании часто пытаются использовать готовые модели в NLP-системе, но обнаруживают, что специальной настройки этого оказывается недостаточно», — сказал он. Именно тогда выясняется, что точность системы оставляет желать лучшего. «Что вам действительно нужно, так это возможности, знания и ПО, чтобы до крайней степени упростить обучение и настройку ваших моделей в соответствии с конкретными потребностями. Именно здесь сейчас создается множество новых инструментов, таких как AutoNLP и активное обучение», — отметил он.

Еще одной востребованной опцией являются инструменты аннотирования данных, которые включают в себя возможности активного и трансфертного обучения, позволяющие обучить NLP делать аннотации, как это делает человек. «Цель состоит в том, как быстро вы сможете найти такого эксперта и создать модель, которая, по сути, учится у него, — сказал Талби. — Проблема в том, что большинство людей не являются специалистами по данным. Мы должны предоставить им пользовательские интерфейсы, в которых они аннотируют данные, чтобы получать документы. Но затем вам нужно автоматизированное ПО в бэкэнде для трансфертного обучения языковой модели, что, по сути, даст вам настроенную модель для конкретной проблемы, которую вы хотите решить».

Некоторые пользователи NLP сегодня жалуются на недостаточную точность систем «из коробки». Эти ожидания должны быть скорректированы, чтобы они знали, что для достижения своих целей им необходимо добавить настройки, но при этом они должны быть более простыми. В конечном итоге индустрия NLP должна обучать пользователей, чтобы сделать технологию более прозрачной и ценной для них, считает Талби: «Дело не в более мощных компьютерах, GPU или более крупных моделях — проблема в том, что люди не знают, как пользоваться этими инструментами».

По его словам, это похоже на изобретение двигателя внутреннего сгорания. «Нам нужно было пройти определенный путь, чтобы у каждого был автомобиль. Сначала нужно было сделать их простыми в использовании. Затем люди должны были научиться водить машину. NLP еще не достигла этого. Нам предстоит большая работа. Каждый водитель не может быть инженером-механиком, — утверждает он. — Это область, которая еще только зарождается, и люди все еще разбираются в ней. У них также много других приоритетов в бизнесе и ИТ. Но NLP — это работа с текстом, и возможность отвечать на вопросы по тексту становится очень важной задачей».

Талби признал, что индустрия еще не достигла всех этих целей, и разработчикам предстоит внести корректировки и улучшения с участием пользователей, чтобы все это хорошо работало. «Именно здесь и кроются трудности, — сказал Талби. — У нас есть документы. Есть примеры использования. Три года назад это было просто невозможно. Но потребуется еще много инноваций, чтобы сделать NLP проще и применимее в реальных условиях, чтобы технология справлялась с исключениями и предубеждениями и масштабировалась».