Языковые модели генеративного ИИ, такие как ChatGPT, захватили наше воображение, потому что впервые мы можем видеть, что ИИ ведет с нами беседу, как настоящий человек, и генерирует эссе, стихи и другой новый контент, который мы считаем творческим. Генеративные ИИ-решения кажутся полными революционного потенциала для более быстрого и качественного внедрения инноваций, повышения производительности и ускорения создания ценности. Тем не менее, их ограничения еще не получили широкого распространения, равно как и передовые методы обеспечения конфиденциальности данных и управления ими, пишет на портале Datanami Кришна Субраманиан, президент и операционный директор поставщика решений для управления неструктурированными данными Komprise.

В последнее время многие представители технологического сообщества и сообщества безопасности подают тревожные сигналы в связи с отсутствием понимания и достаточных нормативных ограждений в отношении использования технологий ИИ. Мы уже видим обеспокоенность по поводу надежности результатов, получаемых с помощью инструментов ИИ, утечек интеллектуальной собственности и персональных данных, а также нарушений конфиденциальности и безопасности.

2023-й станет годом, который мы будем вспоминать как начало эпохи ИИ, вызванное технологией, о которой все говорят — ChatGPT.

Инцидент Samsung с ChatGPT попал в заголовки новостей после того, как технологический гигант невольно слил свои собственные секреты в ИИ-сервис. Samsung не одинока: исследование Cyberhaven показало, что 4% сотрудников поместили конфиденциальные корпоративные данные в большую языковую модель (LLM). Многие не знают, что когда они обучают модель с помощью своих корпоративных данных, ИИ-провайдер может повторно использовать эти данные в другом месте.

«В течение нескольких дней после запуска ChatGPT мы выявили множество субъектов угроз в дарквебе и форумах со специальным доступом, которые делились не только уязвимостями, но и функциональными вредоносными программами, учебниками по социальной инженерии, схемами зарабатывания денег и многим другим — все это стало возможным благодаря использованию ChatGPT», — это откровение от аналитической фирмы по кибербезопасности Recorded Future звучит так, что будто мы готовы лучше снабжать киберпреступников,

Что касается конфиденциальности, то когда человек регистрируется в таком инструменте, как ChatGPT, тот может получить доступ к IP-адресу, настройкам браузера и активности просмотра — точно так же, как и современные поисковые системы. Но риск выше, потому что «без согласия человека могут быть раскрыты его политические убеждения или сексуальная ориентация, что может привести к разглашению постыдной или даже губительной для карьеры информации», — говорит Хосе Блайя, директор по инженерии компании Private Internet Access.

Очевидно, что нам нужны более совершенные правила и стандарты для внедрения этих новых технологий ИИ. Однако здесь не хватает обсуждения важной роли управления и администрирования данными, поскольку это может сыграть решающую роль в принятии и безопасном использовании ИИ на предприятиях.

Все дело в данных

Вот три области, на которых нам следует сосредоточиться:

- Администрирование и прозрачность учебных данных. Основная проблема связана с проприетарными предварительно обученными моделями ИИ, такими как LLM. Программы машинного обучения, использующие LLM, охватывают массивные наборы данных из многих источников. Однако LLM — это черный ящик, который практически не обеспечивает прозрачности исходных данных. Мы не знаем, являются ли источники достоверными, непредвзятыми, точными или незаконными, поскольку содержат персональные или мошеннические данные. OpenAI, например, не делится своими исходными данными. Газета Washington Post проанализировала набор данных Google C4, охватывающий 15 млн. веб-сайтов, и обнаружила десятки нежелательных сайтов, содержащих подстрекательские и персональные данные, а также другой сомнительный контент. Нам необходимо администрирование данными, которое требует прозрачности используемых источников данных и достоверности/надежности знаний из этих источников. Например, ваш ИИ-бот мог обучиться на данных из непроверенных источников или сайтов фейковых новостей, и теперь искаженные знания являются частью новой политики или плана НИОКР в вашей компании.

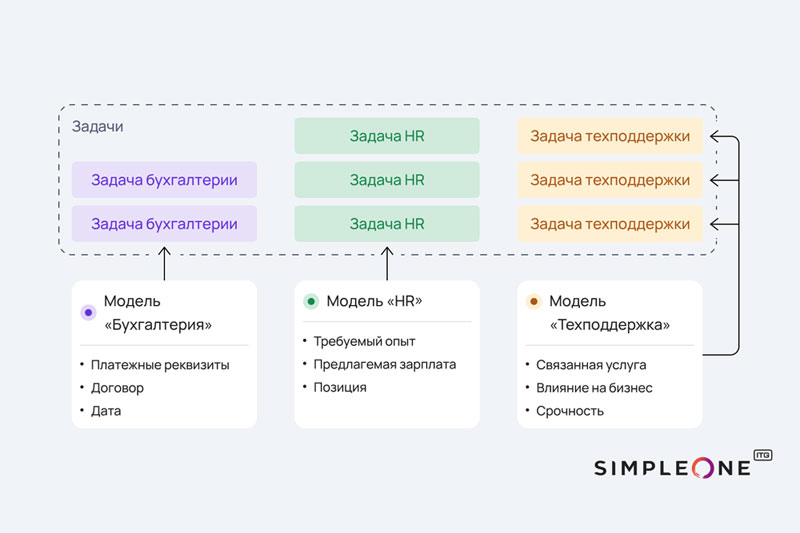

- Разделение данных и домены данных. В настоящее время различные поставщики ИИ имеют разные политики в отношении того, как они обращаются с конфиденциальностью предоставленных вами данных. Ваши сотрудники могут невольно передавать данные в своих подсказках LLM, не зная, что модель может включить ваши данные в свою базу знаний. Компании могут невольно раскрывать коммерческие секреты, программный код и личные данные. Некоторые ИИ-решения предлагают обходные пути, такие как API, которые защищают конфиденциальность данных, не допуская попадания ваших данных в предварительно обученную модель, но это ограничивает их ценность, поскольку идеальным вариантом использования является дополнение предварительно обученной модели вашими данными, специфичными для конкретной ситуации, при сохранении их конфиденциальности. Одно из решений заключается в том, чтобы инструменты ИИ, прошедшие предварительное обучение, понимали концепцию «доменов» данных. «Общий» домен данных для обучения используется для предварительного обучения, и он является общим для всех подразделений, в то время как «собственные данные», используемые для дополнения модели обучения, надежно ограничены рамками вашей организации. Управление данными может обеспечить создание и поддержание этих границ.

- Производные результаты. Третья область управления данными связана с данными, сгенерированными в процессе работы ИИ, и их конечным владельцем. Допустим, я использую ИИ-бота для решения задачи кодирования. Обычно, если что-то было сделано неправильно и привело к багам или ошибкам, я могу выяснить, кто и что сделал путем расследования, и исправить. В случае же с ИИ моя организация несет ответственность за любые ошибки или плохие результаты, возникшие в результате выполнения задачи, которую я попросил ИИ выполнить — даже если у нас нет прозрачности процесса или исходных данных. Вы не можете винить машину: где-то на одном из этапов ошибку или плохой результат вызвал человек. А как насчет интеллектуальной собственности? Принадлежит ли вам произведение, созданное с помощью генеративного ИИ-инструмента? Как вы будете защищать это в суде? По данным Harvard Business Review, в мире искусства уже ведутся судебные иски.

Тактика управления данными, которую следует рассмотреть уже сейчас

На этой ранней фазе мы еще не знаем, чего не знаем об ИИ в отношении рисков, связанных с плохими данными, конфиденциальностью и безопасностью, интеллектуальной собственностью и другими чувствительными вещами. Кроме того, ИИ является широкой областью с множеством подходов, таких как LLM и автоматизация на основе логики — это лишь некоторые из тем, которые необходимо изучить с помощью комбинации политик администрирования данными и практик управления данными. Поэтому:

- Отложите эксперименты с генеративным ИИ до тех пор, пока у вас не появится система администрирования, контролирующая стратегию, политику и процедуры для снижения рисков и подтверждения результатов.

- Внедрите руководящие принципы управления данными: все начинается с глубокого понимания собственных данных, где бы они ни находились. Где находятся ваши конфиденциальные данные и данные клиентов? Сколько у вас данных об интеллектуальной собственности и где хранятся эти файлы? Можете ли вы контролировать их использование, чтобы убедиться, что эти типы данных случайно не попали в инструмент ИИ, и предотвратить нарушение безопасности или конфиденциальности?

- Не предоставляйте ИИ-приложению больше данных, чем требуется, и не делитесь конфиденциальными, закрытыми данными. Блокируйте/шифруйте данные об интеллектуальной собственности и данные клиентов, чтобы предотвратить их распространение.

- Выясните, может ли ИИ-инструмент быть прозрачным в плане источников данных.

- Может ли поставщик защитить ваши данные? «Независимо от того, обучает ли компания модель в Vertex AI или создает опыт обслуживания клиентов в Generative AI App Builder, частные данные сохраняются в тайне и не используются в более широком корпусе обучения базовой модели», — заявляет Google в своем блоге, но «как» она это делает, остается неясным. Ознакомьтесь с договорными формулировками каждого инструмента ИИ, чтобы понять, могут ли данные, которые вы ему предоставляете, оставаться конфиденциальными.

- Пометьте данные из производных работ владельца, или человека, или отдела, заказавшего проект. Это полезно, поскольку вы можете нести конечную ответственность за любую работу, выполненную в вашей компании, и вам следует знать, как и кем ИИ был включен в процесс.

- Обеспечьте переносимость данных между доменами. Например, какая-то команда может захотеть очистить данные от своей интеллектуальной собственности и идентификационных характеристик и включить их в общий набор учебных данных для дальнейшего использования. Автоматизация и отслеживание этого процесса крайне важны.

- Будьте в курсе всех разрабатываемых отраслевых правил и рекомендаций и общайтесь с коллегами из других организаций, чтобы узнать, как они подходят к снижению рисков и управлению данными.

- Перед началом любого проекта по генеративному ИИ проконсультируйтесь с экспертом по правовым вопросам, чтобы понять риски и процессы, которым необходимо следовать в случаях утечки данных, нарушения конфиденциальности и прав интеллектуальной собственности, действий злоумышленников или ложных/ошибочных результатов.

Прагматичный подход к ИИ на предприятии

ИИ стремительно развивается и открывает огромные перспективы, позволяя ускорять инновации, сокращать расходы и улучшать пользовательский опыт невиданными ранее темпами. Однако, как и большинство мощных инструментов, ИИ необходимо использовать осторожно и в правильном контексте, обеспечивая надлежащее управление и администрирование данными. Четкие стандарты управления данными при использовании ИИ еще не выработаны, и эта область требует дальнейшего изучения. Тем временем, прежде чем использовать приложения ИИ, предприятиям следует проявлять осторожность и четко понимать риски раскрытия данные, утечки данных и потенциального нарушения безопасности данных.