Опрошенные порталом ComputerWeekly эксперты обсуждают ключевые факторы влияния искусственного интеллекта на хранение данных, включая ввод-вывод (I/O) и возможные здесь узкие места, I/O-различия при обучении и выводе, а также проблемы управления данными и соблюдения нормативных требований.

ИИ — одна из самых быстрорастущих корпоративных технологий. По данным IBM, 42% компаний с числом сотрудников более 1000 человек уже используют ИИ в своей деятельности. Еще 40% тестируют или экспериментируют с ним.

Большая часть этих инноваций приходится на генеративный ИИ (GenAI) или большие языковые модели (LLM), такие как ChatGPT. Все чаще эти формы ИИ используются в корпоративных приложениях или чат-ботах, взаимодействующих с клиентами.

Пока большинство систем GenAI работают в облаке, но поставщики работают над тем, чтобы упростить интеграцию LLM с корпоративными данными.

LLM и более «традиционные» формы ИИ и машинного обучения требуют значительных ресурсов для вычислений и хранения данных, как локальных, так и облачных.

Ниже рассмотрены некоторые проблемы, связанные с хранением данных, а также необходимость соблюдения нормативных требований на этапах обучения и эксплуатации ИИ.

Обучение ИИ предъявляет высокие I/O-требования к СХД

Модели ИИ необходимо обучать перед использованием. Чем лучше обучение, тем надежнее модель — и чем больше обучающих данных, тем лучше.

«Важнейшим аспектом любой модели является то, насколько она хороша, — говорит Рой Иллсли, главный аналитик практики облачных вычислений и центров обработки данных компании Omdia. — Это адаптация поговорки „Плохие данные плюс идеальная модель равны плохому прогнозированию“, которая говорит сама за себя. Данные должны быть чистыми, надежными и доступными».

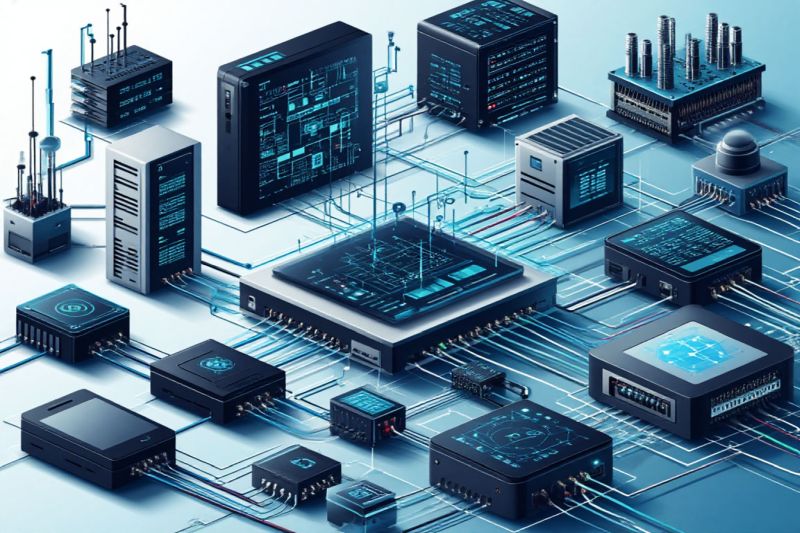

В результате проекты ИИ предъявляют наибольшие требования к ИТ-инфраструктуре, в том числе к СХД, именно на этапе обучения. Однако единой архитектуры хранения данных, поддерживающей ИИ, не существует. Тип хранилища зависит от типа данных.

Обучение LLM чаще всего происходит на неструктурированных данных. Обычно они хранятся в файловых или объектных хранилищах. В то же время финансовые модели используют структурированные данные, для которых более распространены блочные хранилища. А в некоторых ИИ-проектах будут использоваться все три типа хранилищ.

Еще один фактор — место обучения модели. В идеале данные должны находиться как можно ближе к вычислительным ресурсам.

Для облачной модели это делает типичным выбором облачное хранилище. Узкие места ввода-вывода в облачной инфраструктуре — меньшая проблема, чем задержки при перемещении данных в облако или из него, а гипермасштабируемые облачные провайдеры сегодня предлагают целый ряд высокопроизводительных вариантов хранения.

Обратное тоже применимо. Если данные находятся онпремис, например в корпоративной базе данных или ERP-системе предприятия, то для выполнения модели имеет смысл использовать локальные вычисления. Это позволит разработчикам ИИ получить больше контроля над конфигурацией оборудования.

В моделях ИИ широко используются графические процессоры (GPU), которые стоят дорого, поэтому важно, чтобы система хранения успевала за требованиями GPU. Однако в некоторых случаях центральные процессоры (CPU) могут оказаться более узким местом, чем хранилище. Все зависит от типа модели, данных, на которых она обучается, и доступной инфраструктуры.

«Она должна быть максимально эффективной, — говорит Патрик Смит, технический директор компании Pure Storage в регионе EMEA. — В этом и заключается суть. Вам нужна среда, сбалансированная с точки зрения возможностей и производительности GPU, сети и внутреннего хранилища».

То, как компания планирует использовать свою модель ИИ, также влияет на выбор хранилища — локального или облачного. Если этап обучения ИИ будет непродолжительным, облачное хранилище, скорее всего, окажется наиболее экономичным, а ограничения по производительности — менее острыми. После завершения обучения предприятие может свернуть хранилище.

Однако если данные необходимо сохранить на этапе эксплуатации — для тонкой настройки, непрерывного обучения или работы с новыми данными, — то преимущества облака, основанные на принципе «по требованию», ослабевают.

Выводы ИИ требуют низкой задержки

Как только модель обучена, ее требования к хранению данных должны снизиться. Производственные системы ИИ выполняют запросы пользователей или клиентов с помощью настроенных алгоритмов, и они могут быть очень эффективными.

«Модель, полученная в результате обучения ИИ, обычно невелика по сравнению с масштабом вычислительных ресурсов, использованных для ее обучения, и не требует слишком много места для хранения данных», — говорит Кристоф Штурманн, директор по облачным технологиям Taiga Cloud, входящей в Northern Data Group.

Тем не менее, у системы всегда есть входные и выходные данные. Пользователи или приложения вводят запросы в модель, а модель затем аналогичным образом выдает свои результаты. На этом этапе работы, или этапе вывода, ИИ требуется высокая I/O-производительность. Объем требуемых данных может быть на порядки меньше, чем при обучении, но время ввода данных и выдачи запросов может измеряться миллисекундами.

Некоторые ключевые области применения ИИ, такие как кибербезопасность и обнаружение угроз, автоматизация ИТ-процессов, биометрическое сканирование для обеспечения безопасности или распознавание изображений в производстве, требуют быстрых результатов.

Даже в тех случаях, когда генеративный ИИ (GenAI) используется для создания чат-ботов, взаимодействующих как люди, система должна быть достаточно быстрой, чтобы ответы выглядели естественными.

Опять же, все зависит от модели и от того, что должна делать система ИИ. «Некоторые приложения требуют очень низкой задержки, а данные могут составлять очень небольшую часть приложения, — говорит Иллсли. — В этом случае ИИ должен располагаться как можно ближе к пользователю. Другие приложения могут быть менее чувствительны к задержкам, но содержать большие объемы данных, и тогда необходимо, чтобы ИИ располагался рядом с хранилищем, обладающим необходимой емкостью и производительностью».

Управление данными для ИИ

Третье влияние ИИ на СХД — это постоянная необходимость сбора и обработки данных.

Работая с «обычным» ИИ и машинным обучением, специалисты в области науки о данных хотят получить доступ к как можно большему количеству данных на том основании, что чем больше данных, тем более точную модель можно создать.

С этим связан более широкий подход организации к управлению данными и их хранению. Здесь необходимо учитывать, хранятся ли данные на флэш-накопителях или на магнитных дисках, где хранятся архивы и какова политика хранения исторических данных.

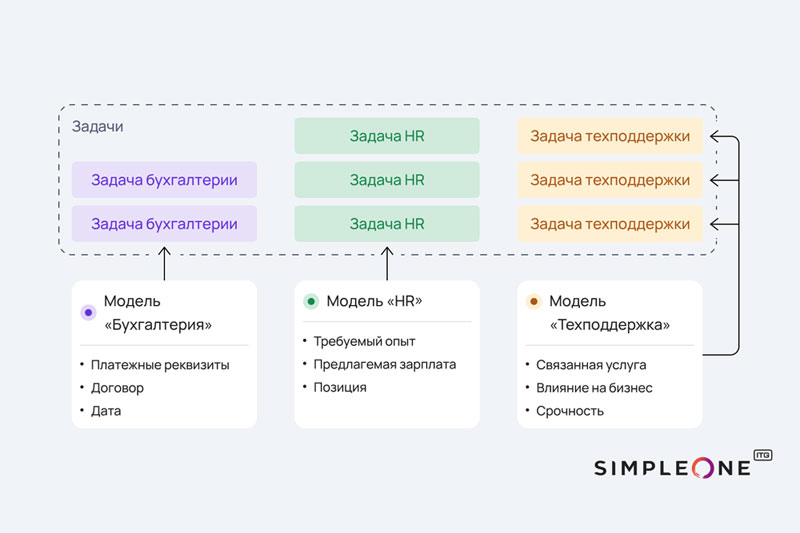

На этапе обучения ИИ и формирования выводов будут использоваться данные из всех подразделений организации, в том числе из различных приложений, от людей и датчиков.

Разработчики ИИ начали рассматривать ткани данных (data fabrics) как один из способов «подпитки» систем ИИ, однако их производительность может стать проблемой. Вероятно, ткани данных придется строить на разных уровнях хранения, чтобы сбалансировать производительность и стоимость.

На данный момент развертывание GenAI — относительно несложная задача, поскольку LLM обучаются на данных из Интернета, но ситуация будет меняться по мере того, как все больше компаний будут стремиться использовать LLM на собственных данных.

ИИ, хранение данных и комплаенс

Предприятия должны быть уверены в том, что их ИИ-данные защищены и хранятся в соответствии с местными законами и нормами.

Это будет влиять на место хранения данных, поскольку регулирующие органы все больше беспокоятся о суверенитете данных. При использовании облачных сервисов ИИ возникает необходимость понимать, где хранятся данные на этапах обучения и формирования выводов. Организациям также необходимо контролировать, как они хранят входные и выходные данные модели.

Это относится и к моделям, работающим на локальных системах, хотя существующие политики защиты данных и соблюдения нормативных требований должны охватывать большинство сценариев использования ИИ.

Тем не менее, стоит проявлять осторожность. «Лучше всего продумать, какие данные пойдут в тренировочный пул для обучения ИИ, и четко определить, какие данные вы хотите и не хотите сохранять в модели, — говорит Ричард Уотсон-Брюн, эксперт PA Consulting по безопасности данных. — Когда компании используют такие инструменты, как ChatGPT, может быть абсолютно нормально хранить эти данные в облаке и передавать их за границу, но при этом необходимо предусмотреть условия контракта, регулирующие такой обмен».