Джимми Места, основатель и технический директор компании RAD Security, рассказывает на портале The New Stack о том, почему разработчики внедряют искусственный интеллект за вашей спиной — и как это обнаружить.

Несколько месяцев назад платформенный инженер в одной из средних финтех-компаний подключил большую языковую модель (LLM) от OpenAI к конвейеру Terraform. Он не пытался скрыть это. Он просто хотел автоматически помечать облачные ресурсы, а LLM справляется с этой задачей лучше и быстрее, чем все, что его команда создала своими силами. Но об этом узнала служба безопасности. И началось: паника по поводу аудита, проверка рисков, ретроактивные разрешения... Звучит знакомо?

LLM теперь представляют собой новые теневые ИТ. Они проникают в рабочую среду быстрее, чем большинство организаций успевает их отследить.

Теневой ИИ означает, что разработчики интегрируют LLM или системы генеративного ИИ (GenAI) в производственные рабочие процессы без согласования. Они тестируют подсказки на живых данных клиентов, вызывают LLM из неавторизованных скриптов и запускают тонко настроенные модели на кластерах GPU без уведомления служб безопасности и управления. Хотя разработчики, возможно, и не собираются создавать риски, эти действия полностью обходят видимость, контроль и политику.

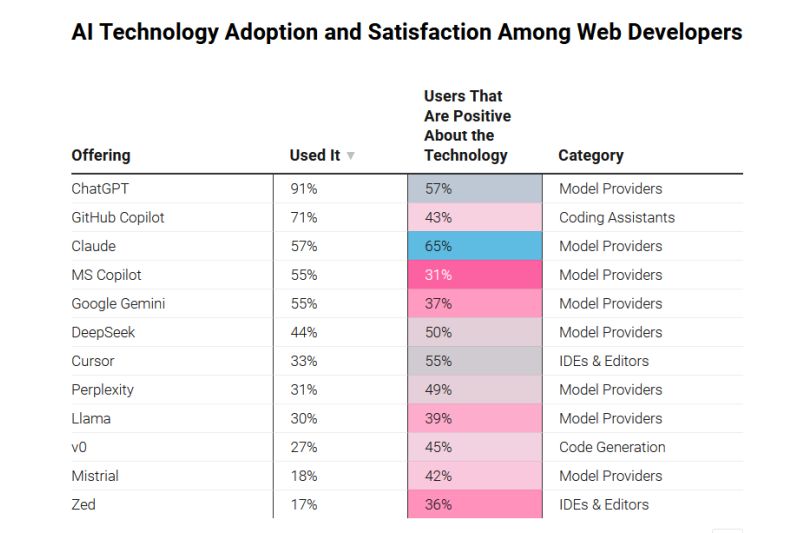

Почему это происходит? Потому что разработчикам не нужно разрешение на установку пакета Python. Потому что использовать ключ API проще, чем отправить Jira-тикет. Потому что ИИ работает. И это то, о чем никто не хочет говорить: эти инструменты часто оказываются более полезными, чем санкционированные альтернативы.

Мы видим, как LLM используются для автоматической маркировки инфраструктуры, классификации предупреждений, генерации документов, соответствующих нормативным требованиям, и создания внутренних инструментов поиска поверх баз знаний. Мы также видим, как они незаметно встраиваются в рабочие процессы CI/CD, скрываясь в сценариях, которые никто не просматривает. Иногда они даже попадают в производственные конвейеры, и никто не замечает зависимостей. Это не гипотетические крайние случаи — они происходят в каждой компании, с которой мы общаемся.

Теневой ИИ — это не просто разработчик, срезающий углы. Это сигнал. Он подсказывает вам, где ваш инструментарий слишком медленный, слишком жесткий или просто отсутствует. Но вы теряете доверие, если игнорируете его — или, что еще хуже, пытаетесь зажать, не предлагая альтернатив. Вы загоняете эту деятельность еще глубже в подполье. И в конечном итоге вы расплачиваетесь за это нарушениями, провалом аудита или кошмаром поддержки, когда никто не знает, как работает этот операционный конвейер.

Риски реальны. Разработчики могут устроить утечку персональных данных или проприетарной логики, отправляя подсказки во внешние API. Они могут устроить разрастание моделей — рабочие процессы-зомби, которые никто не поддерживает и которыми никто не владеет. Они могут внедрить невидимые зависимости, которые тихо перекочуют из одной среды в другую. И все это при нулевом протоколировании, отсутствии процесса проверки и аудиторского следа.

Некоторые организации начинают наверстывать упущенное. Они создали правила обнаружения, которые отмечают исходящий трафик к OpenAI или Anthropic. Они сканируют исходный код на предмет API моделей или подозрительного поведения во время выполнения. Они изучают шаблоны телеметрии и отслеживают аномалии, напоминающие использование подсказок. Иногда они даже встраивают возможность наблюдения за LLM в облачные инструменты безопасности или платформы EDR. Пока это первые шаги, но это уже происходит.

Наиболее зрелые команды выходят за рамки точечных обнаружений. Они картируют рабочие нагрузки ИИ, определяют, что они делают и как взаимодействуют с конфиденциальными системами и данными. Они отслеживают не только запуск модели, но и то, кто ее создал, где она живет и соответствует ли политике. Это переход от реагирования на проблемы, которые возникают быстрее, чем вы можете их решать, к устойчивому управлению. Если вы видите, где используется ИИ, вы можете управлять им, направлять и встраивать его, не убивая инновации.

Однако одно лишь обнаружение не решает проблему. Если единственное, что вы будете делать, — это закрывать все подряд, вы оттолкнете разработчиков, пытающихся решать реальные проблемы. Более эффективная стратегия предполагает ограждения, а не блокпосты. Обеспечьте безопасные внутренние шлюзы к утвержденным моделям. Создайте «песочницу» со встроенной возможностью наблюдаемости. Дайте командам возможность экспериментировать с ИИ, не оставляя его незащищенным или невидимым.

Вам все равно понадобится политика. Вам все равно понадобится надзор. Но если вы создадите разумные умолчания, люди будут их использовать. Если вы будете контролировать ситуацию, они будут обходить вас стороной.

LLM уже являются частью вашего стека, независимо от того, планировали вы это или нет. Они встроены в скрипты, конвейеры и рабочие процессы по всей вашей организации. Вы не можете запретить разработчикам использовать LLM. Но вы можете сделать так, чтобы вы не были последним, кто узнал об этом.