Многие компании купаются в данных, которых больше, чем они могут использовать. К сожалению, слишком многие из тех, кто буквально тонет в данных, связывают эту проблему с самими большими данными. С точки зрения технологии, большие данные представляют совершенно особое явление — сочетание структурированных данных (принадлежащей вашей компании информации) с неструктурированными (из общедоступных источников, таких как социальные сети и правительственные органы).

Когда вы накладываете неструктурированные данные поверх структурированных и используете аналитическое ПО для их визуализации, вы можете делать то, чего никогда не могли прежде, — прогнозировать продажи продуктов, более целенаправленно обращаться к клиентам, выявлять новые рынки и т. д.

Большие данные больше не страдают от недостатка инструментов, как несколько лет назад. Тогда работа с большими данными требовала наличия в штате специалистов по данным (data scientists), владеющих инструментами с открытым исходным кодом, такими как R и Hadoop.

Сегодня имеется множество компаний, готовых помочь визуализировать большие данные, начиная с таких специализированных фирм, как Tableau, Qlik, TIBCO и MicroStrategy, и заканчивая разработчиками законченных решений вроде Microsoft, IBM, SAP и Oracle.

Однако, по словам руководителей ИТ-подразделений, выступавших на прошлой неделе в г. Орландо на мероприятии Midmarket CIO Forum / Midmarket CMO Forum, одна из главных трудностей, с которой сталкиваются компании при использовании всех этих аналитических платформ, заключается в загрузке данных.

Один из CIO сказал: «Наша самая большая проблема в области ИТ связана с тем, как загрузить данные. Вот настоящее мучение».

Знаменательно, что это утверждение подкрепляется результатами исследований.

Согласно исследованию компании Xplenty, специализирующейся на интеграции данных, треть специалистов по бизнес-интеллекту тратит от 50 до 90% своего времени на очистку сырых данных и подготовку их к загрузке в платформу обработки данных компании. Возможно, это связано с тем, что только 28% компаний считают, что извлекают из своих данных ценность стратегического значения.

Проблема очистки данных означает также, что некоторые из технических специалистов, пользующихся сегодня наибольшим спросом, тратят значительную долю своего времени на отупляющую работу по сортировке и организации наборов данных, прежде чем они будут подвергнуты анализу.

Это явно не очень хорошо масштабируется и серьезно ограничивает потенциал больших данных. А по мере того, как мы собираем все больше и больше данных (с помощью Интернета вещей) трудности только усугубляются.

Имеются три потенциальных решения этой проблемы.

1. Совершенствование аналитического ПО для больших данных. Поскольку на протяжении последних пяти лет многие из этих компаний вкладывали в большие данные значительные средства, маловероятно, что в ближайшем будущем произойдет прорыв в области инструментов, который облегчит очистку данных. Следует ожидать их последовательного улучшения.

2. Подготовка данных становится одним из направлений науки о данных. Подобно помощникам юристов, которые решают важные частные вопросы, те, кто занят подготовкой данных, могли бы делать примерно то же самое для специалистов по данным. В определенном смысле это уже происходит.

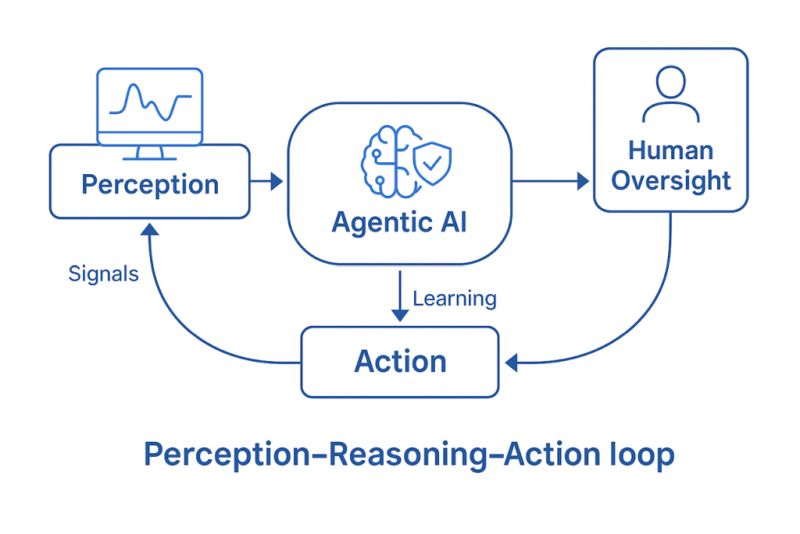

3. ИИ поможет очистке данных. Возможно также, что будут созданы ПО и алгоритмы для очистки, сортировки и категоризации данных. Это обязательно произойдет, но следует также ожидать, что это не станет универсальным решением. Microsoft, IBM и Amazon делают ставку на использование людей для маркировки данных, с чем не может справиться ПО. А это три ведущие корпорации мира в области автоматизации и написания алгоритмов.