Stanford Institute for Human-Centered Artificial Intelligence (HAI) выпустил свой Индекс искусственного интеллекта 2023, в котором анализируется влияние и прогресс ИИ. Отчет представляет собой глубокое погружение в темы, связанные с ИИ, такие как исследования, этика, политика, общественное мнение и экономика, сообщает портал Datanami.

Ключевые выводы исследования касаются того, как расширяются исследования в области ИИ, включая распознавание образов, машинное обучение и компьютерное зрение. В отчете отмечается, что с 2010 г. количество публикаций по ИИ увеличилось более чем в два раза. Несмотря на это, индустриальное развитие ИИ опережает академические исследования: в отчете приводятся 32 значимые модели машинного обучения, созданные бизнесом, и всего три, созданные академическими кругами. Авторы исследования объясняют это огромными ресурсами, необходимыми для обучения этих крупных моделей.

Традиционные бенчмарки ИИ, такие как эталон классификации изображений ImageNet и тест на понимание прочитанного SQuAD, уже недостаточны для измерения прогресса, что привело к появлению новых эталонов, таких как BIG-bench и HELM. Ванесса Парли, помощник директора HAI и член руководящего комитета AI Index, объясняет это тем, что многие эталоны ИИ достигли точки насыщения, когда улучшения практически не происходят, и что исследователи должны разработать новые эталоны, основанные на том, как общество хочет взаимодействовать с ИИ. Она приводит в пример ChatGPT и то, как он проходит многие эталонные испытания, но при этом часто выдает неверную информацию.

Этические проблемы, такие как предвзятость и дезинформация, были еще одним аспектом ИИ, рассмотренным в отчете. С ростом популярности таких моделей генеративного ИИ, как DALL-E 2, Stable Diffusion и, конечно же, ChatGPT, этические злоупотребления ИИ становятся все более распространенными. В отчете отмечается, что количество инцидентов и противоречий, связанных с ИИ, увеличилось в 26 раз с 2012 г. (согласно базе данных AIAAIC, независимого репозитория данных, связанных с неправильным использованием ИИ). Кроме того, интерес к этике ИИ стремительно растет, так как, согласно исследованию, количество заявок на участие в конференции по этике ИИ FAccT более чем удвоилось с 2021 г., а с

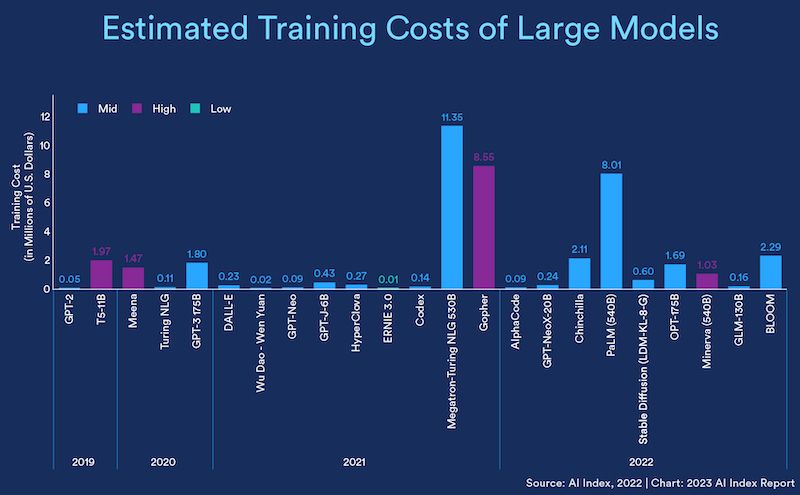

Большие языковые модели срывают банк своим возросшим размером. В отчете приводится пример модели PaLM от Google, выпущенной в 2022 г., — отмечается, что она оказалась в 160 раз дороже и в 360 раз больше, чем GPT-2 от OpenAI в 2019 г. В целом, чем больше модель, тем выше стоимость обучения. По оценкам исследователей, обучение модели Chinchilla компании Deepmind и BLOOM компании HuggingFace обошлось в 2,1 и 2,3 млн. долл. соответственно.

В глобальном масштабе частные инвестиции в ИИ в

Еще одной темой, представляющей интерес, является растущее внимание к ИИ правительств. В отчете были проанализированы законодательные документы 127 стран и обнаружено, что в 2022 г. было принято 37 законопроектов, содержащих «искусственный интеллект», по сравнению с одним в 2016 г. В судах также наблюдается резкий рост числа судебных дел, связанных с ИИ: в 2022 году рассматривалось 110 таких дел, связанных с гражданским правом, интеллектуальной собственностью и договорным правом.