Конечно, можно собрать собственные средства управления данными и запустить их на базе озера-хранилища (lakehouse), оснащенного выбранными вами механизмами обработки данных. Или же можно воспользоваться готовой тканью данных (data fabric), интегрированной в архитектуру lakehouse, от одного из технологических поставщиков, недавно представивших подобные предложения. Об аспектах выбора рассказывает портал Datanami.

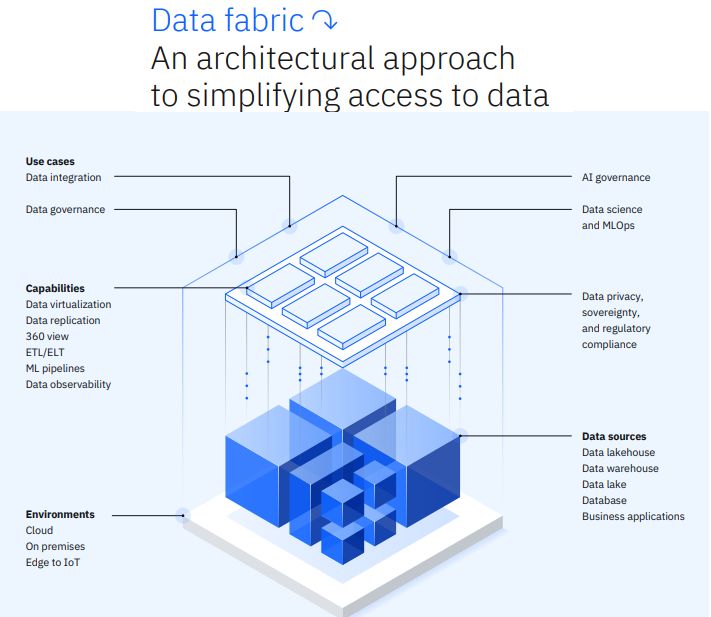

В последние несколько лет ткань данных набирает популярность как архитектурный элемент, позволяющий рецентрализовать управление данными в условиях неуклонного роста разрозненных хранилищ данных. Традиционная ткань данных объединяет на уровне метаданных различные средства управления данными, включая ETL, администрирование, отслеживание истории, каталог данных и контроль доступа, с целью облегчения администраторам предоставления пользователям контролируемого и нехаотичного доступа к разрозненным хранилищам данных.

Многие крупные компании создали свои собственные ткани данных путем интеграции различных лучших в своих классах продуктов. Некоторые поставщики средств управления данными, в том числе Informatica, IBM, Talend и др., предложили свои собственные пакеты. О том, как оценивает данный рынок аналитик компании Forrester Ноэль Юханна (которому приписывается введение термина «ткань данных»), читайте здесь.

Однако новый импульс, приданный ткани данных компаниями IBM, HPE и Microsoft, указывает на то, что рынок, возможно, готов к предложениям готовых тканей данных. В течение трех недель подряд в мае эти компании представили новые предложения по тканям данных или обновили существующие ткани данных, добавив в них новые возможности lakehouse, призванные упростить интеграцию и анализ больших массивов данных без отказа от централизованного управления и безопасности в гибридных облачных средах.

IBM дала старт весеннему фестивалю на рынке ткани данных, представив 9 мая watsonx.data. Технически это решение представляет собой озеро-хранилище, использующее облачное объектное хранилище, работающее в AWS или IBM Cloud, а также движки Presto и Apache Spark для обработки данных (и старые движки Db2 и Netezza для существующих клиентов). Согласованность данных обеспечивает Apache Iceberg. Озеро-хранилище данных watsonx.data тесно связано с платформой IBM Cloud Pak for Data, которая в большей степени выполняет роль традиционной ткани данных со встроенными функциями администрирования, интеграции, обеспечения конфиденциальности и безопасности.

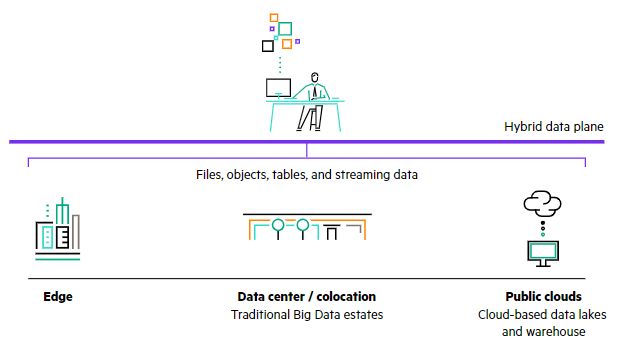

Неделю спустя, 16 мая, компания HPE представила апдейт Ezmeral Data Fabric. Обновленное решение основано на технологии MapR и включает в себя поддержку хранилищ S3, Posix и Kafka, а также Iceberg и Delta — формата таблиц Databricks. Главной новостью стало то, что HPE связала Ezmeral Data Fabric со своей новой системой Unified Analytics, которая включает «кубернетизированные» версии Spark, Apache Superset, Apache Airflow, Feast, Kubeflow, MLFlow, Presto SQL и Ray. Движки изолированы в контейнерах, что позволяет ограничить их «радиус взрыва» — урок, полученный еще во времена Hadoop.

Через неделю после этого, 23 мая, дебютировала Microsoft Fabric. Это предложение, а также OneLake (новое название озера-хранилища компании) призваны стать единым центром управления данными, аналитики и машинного обучения в организации. Microsoft Fabric обеспечивает администрирование данных, ETL, обнаружение данных, обмен ими, контроль их происхождения и соответствия нормативным требованиям. Данные хранятся в Delta — что свидетельствует о более тесном партнерстве Microsoft с Databricks, — а для работы с ними могут использоваться различные продукты для хранения данных и искусственного интеллекта из облака Azure (не говоря уже о движках Databricks).

По словам Маниша Пателя, соучредителя и директора по продуктам компании CData Software, предоставляющей услуги по подключению данных, эти объявления свидетельствуют о том, что заказчики стремятся к более легкому переходу к большим данным, а поставщики готовы предоставить такие возможности. «IBM, HP, Microsoft и другие компании пытаются сказать: „Вам не нужно делать это с помощью нескольких продуктов, нескольких технологий, изучать несколько способов выполнения задач, когда вы можете сделать это практически одним способом, обладая знаниями в одной области“, — говорит он. — Это целенаправленные усилия ряда крупных компаний, направленные на то, чтобы сказать: „Мы можем упростить это для вас. Мы предложим вам один способ выполнения задач на основе понятной вам технологии, которую вы уже приобрели в рамках своей организации или бюджета. Зачем искать что-то еще?“»

По словам Пателя, тот факт, что IBM, HPE и Microsoft сделали столь схожие анонсы data fabric и lakehouse, свидетельствует о наличии большого спроса на рынке. Но отчасти это также результат эволюции архитектуры данных и моделей их использования, считает он.

«Вероятно, есть несколько крупных предприятий, которые скажут: „Слушайте, я больше не могу так делать. Вы должны прийти и исправить это. Мне нужно, чтобы вы сделали это“, — говорит Патель. — Но достигнут и определенный уровень того, куда мы движемся... Администрирование, безопасность и другие вещи становятся все более и более важными и все более и более вплетенными в то, что мы делаем на ежедневной основе. Поэтому меня не удивляет, что некоторые из этих вещей начинают развиваться».

Хотя некоторые организации по-прежнему считают целесообразным выбирать лучшие продукты в каждой категории компонентов ткани данных, многие с радостью откажутся от новейших функций в одной конкретной области в пользу целостной ткани данных, с которой они могут сразу начать работать. Возможно, это также связано с ростом уровня зрелости решений data fabric и признанием того, что это ценная модель доступа к данным.

По словам Пателя, это также может быть побочным эффектом экономической нестабильности и более пристального внимания к расходам на ИТ, особенно в облаке. «Я думаю, что в период расцвета было приятно говорить: „Эй, у меня есть продукт, который делает XY и на Z больше, или XY и на Z лучше“, потому что это могло быть дифференциатором или обеспечивало ценность, — говорит он. — Но как только люди начинают следить за затратами, то начинают отказываться от некоторых из этих идей... Это перераспределение расходов, а не полное их сокращение».